Cette page contient des termes du glossaire des forêts d'arbres décisionnels. Pour tous les termes du glossaire, cliquez ici.

A

échantillonnage d'attributs

Une tactique d'entraînement d'une forêt de décision dans laquelle chaque L'arbre de décision ne considère qu'un sous-ensemble aléatoire de possibilités features lors de l'apprentissage de la condition. En règle générale, un sous-ensemble différent de caractéristiques est échantillonné pour chaque node. En revanche, lors de l'entraînement d'un arbre de décision, sans échantillonnage d'attributs, toutes les caractéristiques possibles sont prises en compte pour chaque nœud.

condition d'alignement sur l'axe

Dans un arbre de décision, une condition impliquant une seule fonctionnalité. Par exemple, si la zone est une caractéristique, ce qui suit est une condition alignée sur les axes:

area > 200

À comparer à la condition oblique.

B

bagging

Méthode permettant d'entraîner un ensemble dans lequel chaque Le modèle constitutif est entraîné sur un sous-ensemble aléatoire de l'entraînement exemples échantillonné avec remplacement. Par exemple, une forêt aléatoire est un ensemble arbres de décision entraînés à l'aide de bagages ;

Le terme bagging est l'abréviation de bootstrap aggrégat.

condition binaire

Dans un arbre de décision, une condition qui n'a que deux résultats possibles, généralement oui ou non. Par exemple, voici une condition binaire:

temperature >= 100

À comparer à la condition non binaire.

C

état

Dans un arbre de décision, tout nœud qui évalue une expression. Par exemple, la partie suivante d'une l'arbre de décision contient deux conditions:

Une condition est également appelée un fractionnement ou un test.

Contraste de la condition avec la condition leaf.

Voir également :

D

Forêt de décision

Modèle créé à partir de plusieurs arbres de décision Une forêt de décision effectue une prédiction en agrégeant les prédictions ses arbres de décision. Les types de forêts de décision les plus courants incluent forêts aléatoires et arbres à boosting de gradient.

arbre de décision

Un modèle d'apprentissage supervisé composé d'un ensemble Les conditions et les feuilles sont organisées de façon hiérarchique. Voici un exemple d'arbre de décision:

E

entropie

Dans <ph type="x-smartling-placeholder"></ph> théorie de l'information, une description de l'imprévisibilité d'une probabilité la distribution. L'entropie est également définie comme la quantité informations contenues dans chaque exemple. Une distribution comporte l'entropie la plus élevée possible lorsque toutes les valeurs d'une variable aléatoire sont tout aussi probable.

Entropie d'un ensemble avec deux valeurs possibles "0" et "1" (par exemple, étiquettes d'un problème de classification binaire) utilise la formule suivante:

<ph type="x-smartling-placeholder"></ph> H = -p log p - q log q = -p log p - (1-p) * log (1-p)

où :

- H est l'entropie ;

- p est la fraction de "1". exemples.

- q est la fraction de "0". exemples. Notez que q = (1 - p)

- log est généralement log2. Dans ce cas, l'entropie est un peu.

Par exemple, supposons les éléments suivants :

- 100 exemples contiennent la valeur "1"

- 300 exemples contiennent la valeur "0"

La valeur d'entropie est donc la suivante:

- p = 0,25

- q = 0,75

- H = (-0,25)log2(0,25) - (0,75)log2(0,75) = 0,81 bit par exemple

Un ensemble parfaitement équilibré (par exemple, 200 "0" et 200 "1") aurait une entropie de 1,0 bit par exemple. À mesure qu'un ensemble devient plus déséquilibré, son entropie tend vers 0,0.

Dans les arbres de décision, l'entropie permet de formuler de gain d'informations pour aider splitter sélectionnez les conditions. lors de la croissance d'un arbre de décision de classification.

Comparer l'entropie avec:

- impurité du gini

- Fonction de perte de l'entropie croisée

L'entropie est souvent appelée entropie de Shannon.

F

importances des caractéristiques

Synonyme d'importance des variables.

G

impurité du gini

Métrique semblable à entropie. Séparateurs utilisent des valeurs dérivées soit de l'impurité ou de l'entropie de gini pour composer des conditions pour la classification Arbres de décision. Le gain d'informations est dérivé de l'entropie. Il n'existe pas de terme équivalent universellement accepté pour la métrique dérivée de l'impurité du gini ; Toutefois, cette métrique sans nom est tout aussi importante d'informations supplémentaires.

L'impureté de Gini est également appelée indice gini, ou tout simplement gini.

Arbres de décision à boosting de gradient (GBT)

Type de forêt de décision dans laquelle:

- L'entraînement repose sur boosting de gradient.

- Le modèle faible est un arbre de décision.

boosting de gradient

Algorithme d'entraînement dans lequel les modèles faibles sont entraînés de manière itérative améliorer la qualité (réduire la perte) d'un modèle solide. Par exemple : Il peut s'agir d'un modèle linéaire ou de petit arbre de décision. Le modèle fort devient la somme de tous les modèles faibles entraînés précédemment.

Dans la forme la plus simple de boosting de gradient, à chaque itération, un modèle faible est entraîné à prédire le gradient de perte du modèle fort. Ensuite, la sortie du modèle fort est mise à jour en soustrayant le gradient prédit semblable à la descente de gradient.

où :

- $F_{0}$ est le modèle robuste de départ.

- $F_{i+1}$ est le prochain modèle fort.

- $F_{i}$ est le modèle performant actuel.

- $\xi$ est une valeur comprise entre 0,0 et 1,0 appelée rétrécissement, qui est analogue au taux d'apprentissage en la descente de gradient.

- $f_{i}$ est le modèle faible entraîné à prédire le gradient de perte de $F_{i}$.

Les variations modernes du boosting de gradient incluent également la dérivée secondaire (Hesses) de la perte dans leur calcul.

Les arbres de décision sont souvent utilisés comme modèles peu fiables l'optimisation du gradient. Voir arbres de décision à boosting de gradient.

I

chemin d'inférence

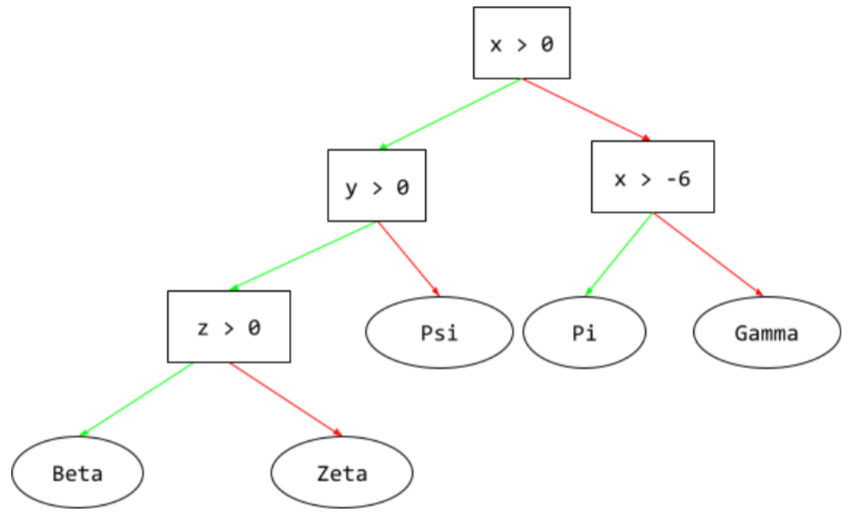

Dans un arbre de décision, lors de l'inférence, l'itinéraire emprunté par un exemple donné à partir du root à d'autres conditions, se terminant par une feuille. Par exemple, dans l'arbre de décision suivant, des flèches plus épaisses indiquent le chemin d'inférence. Voici un exemple : valeurs des caractéristiques:

- x = 7

- y = 12

- z = -3

Dans l'illustration suivante, le chemin d'inférence traverse trois

avant d'atteindre la feuille (Zeta).

Les trois flèches épaisses représentent le chemin d'inférence.

acquisition d'informations

Dans les forêts de décision, la différence entre l'entropie d'un nœud et la valeur pondérée (en fonction du nombre d'exemples) de l'entropie de ses nœuds enfants. L'entropie d'un nœud est l'entropie des exemples de ce nœud.

Prenons l'exemple des valeurs d'entropie suivantes:

- entropie du nœud parent = 0,6

- entropie d'un nœud enfant avec 16 exemples pertinents = 0,2

- entropie d'un autre nœud enfant avec 24 exemples pertinents = 0,1

Ainsi, 40% des exemples se trouvent dans un nœud enfant et 60% dans le un autre nœud enfant. Par conséquent :

- somme d'entropie pondérée des nœuds enfants = (0,4 * 0,2) + (0,6 * 0,1) = 0,14

Le gain d'informations est donc:

- Gain d'informations = entropie du nœud parent - somme d'entropie pondérée des nœuds enfants

- gain d'informations = 0,6 - 0,14 = 0,46

La plupart des spliters cherchent à créer des conditions. qui maximisent l'acquisition d'informations.

condition dans l'ensemble

Dans un arbre de décision, une condition qui teste la présence d'un élément dans un ensemble d'éléments. Par exemple, voici une condition intégrée:

house-style in [tudor, colonial, cape]

Pendant l'inférence, si la valeur de la caractéristique de style maison

est tudor, colonial ou cape, la condition renvoie la valeur Oui. Si

la valeur de la caractéristique "maison" est autre (par exemple, ranch) ;

cette condition renvoie la valeur Non.

Les conditions intégrées conduisent généralement à des arbres de décision plus efficaces que conditions qui testent les caractéristiques de l'encodage one-hot.

L

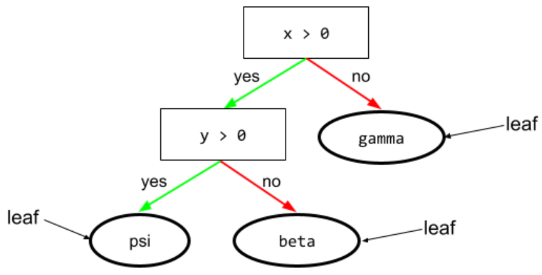

feuille

Tout point de terminaison d'un arbre de décision À la différence d'un condition, une feuille n'effectue pas de test. Une feuille est plutôt une prédiction possible. Une feuille est aussi le terminal nœud d'un chemin d'inférence.

Par exemple, l'arbre de décision suivant contient trois feuilles:

N

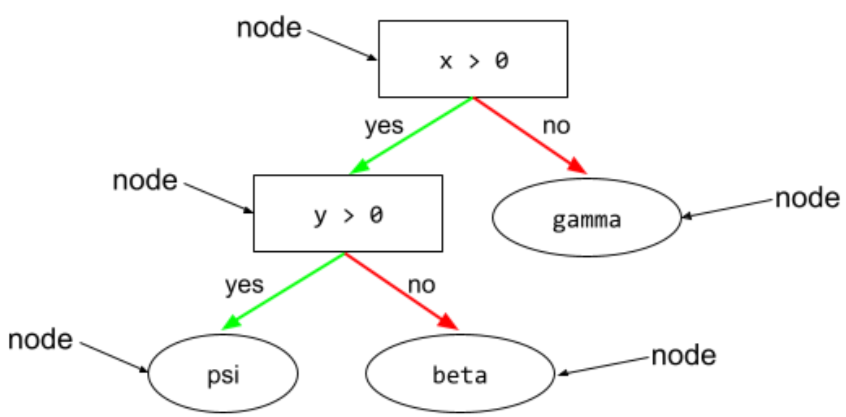

nœud (arbre de décision)

Dans un arbre de décision, toute condition ou leaf.

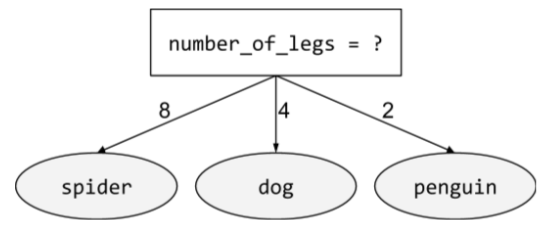

condition non binaire

Une condition qui contient plus de deux résultats possibles. Par exemple, la condition non binaire suivante contient trois résultats:

O

condition oblique

Dans un arbre de décision, condition impliquant plusieurs feature : Par exemple, si la hauteur et la largeur sont deux caractéristiques, alors ce qui suit représente une condition oblique:

height > width

À comparer à la condition d'alignement sur l'axe.

évaluation de l'emballage extérieur

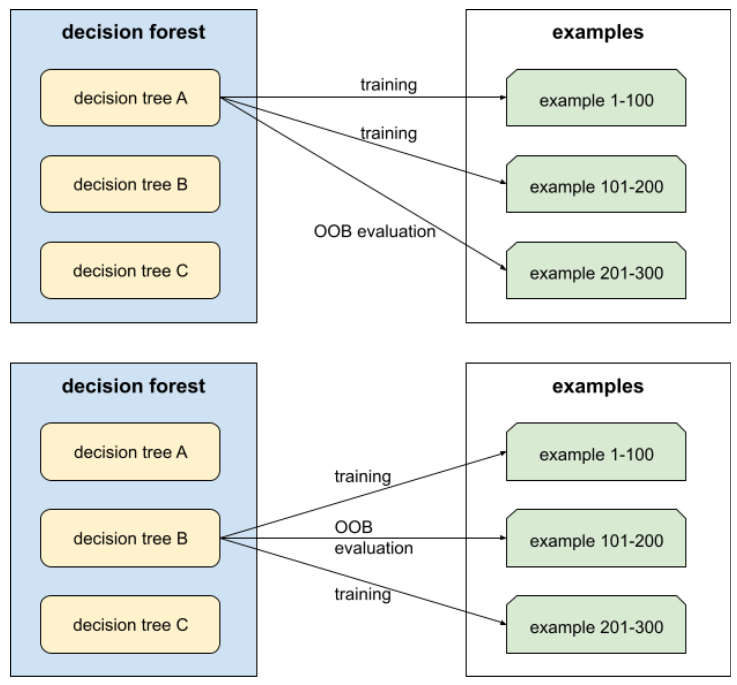

Mécanisme d'évaluation de la qualité d'une forêt de décision en testant chaque d'un arbre de décision exemples non utilisés pendant entraînement de cet arbre de décision. Par exemple, dans Dans le schéma suivant, vous remarquerez que le système entraîne chaque arbre de décision sur environ deux tiers des exemples, puis évalue le tiers restant des exemples.

Cette évaluation est une méthode de calcul efficace et prudente approximation du mécanisme de validation croisée. Lors de la validation croisée, un modèle est entraîné pour chaque cycle de validation croisée. (par exemple, 10 modèles sont entraînés lors d'une validation croisée de 10 fois). Avec l'évaluation OOB, un seul modèle est entraîné. Comme le bagage retient certaines données de chaque arbre pendant l'entraînement, l'évaluation OOB peut utiliser pour se rapprocher de la validation croisée.

P

importances des variables de permutation

Type d'importance de la variable qui évalue l'augmentation de l'erreur de prédiction d'un modèle après avoir permuté la les valeurs de la caractéristique. L'importance de la variable de permutation est une variable la métrique.

R

forêt d'arbres décisionnels

Un ensemble d'arbres de décision chaque arbre de décision est entraîné avec un bruit aléatoire spécifique. comme le bagging.

Les forêts d'arbres décisionnels sont un type de forêt de décision.

racine

Le nœud de départ (le premier condition) dans un arbre de décision. Par convention, les diagrammes placent la racine en haut de l'arbre de décision. Exemple :

S

échantillonnage avec remplacement

Méthode de sélection d'éléments à partir d'un ensemble d'éléments candidats dans laquelle le même l'article peut être sélectionné plusieurs fois. L'expression "avec remplacement" signifie après chaque sélection, l'élément est réintégré dans le groupe. d'éléments candidats. La méthode inverse, échantillonnage sans remplacement, signifie qu'un élément candidat ne peut être sélectionné qu'une seule fois.

Prenons l'exemple de la collection de fruits suivante:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Supposons que le système choisisse de manière aléatoire fig comme premier élément.

Si vous utilisez l'échantillonnage et le remplacement, le système choisit

deuxième élément de l'ensemble suivant:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Oui, c'est le même ensemble qu'avant, le système pourrait donc potentiellement

sélectionnez à nouveau fig.

Si vous utilisez l'échantillonnage sans remplacement, un échantillon ne peut pas être

choisi à nouveau. Par exemple, si le système choisit fig de manière aléatoire comme

premier échantillon, fig ne pourra pas être sélectionné à nouveau. Par conséquent, le système

choisit le deuxième échantillon parmi l'ensemble suivant (réduit) :

fruit = {kiwi, apple, pear, cherry, lime, mango}

rétrécissement

Un hyperparamètre dans boosting de gradient, qui contrôle surapprentissage. Rétrécissement lors de l'optimisation du gradient est analogue au taux d'apprentissage descente de gradient. Le rétrécissement est un nombre décimal comprise entre 0,0 et 1,0. Une valeur de rétrécissement inférieure réduit le surapprentissage qu'une valeur de réduction supérieure.

split

Dans un arbre de décision, un autre nom condition [état].

séparateur

Lors de l'entraînement d'un arbre de décision, la routine (et un algorithme) chargés de trouver le meilleur condition au niveau de chaque nœud.

T

test

Dans un arbre de décision, un autre nom condition [état].

seuil (pour les arbres de décision)

Dans une condition alignée sur l'axe, la valeur qu'une feature est en cours de comparaison. Par exemple, 75 correspond au seuil dans la condition suivante:

grade >= 75<ph type="x-smartling-placeholder">

V

importances des variables

Un ensemble de scores indiquant l'importance relative de chaque feature au modèle.

Prenons l'exemple d'un arbre de décision qui estime le prix des maisons. Supposons que cet arbre de décision utilise les caractéristiques: taille, âge et style. Si un ensemble d'importances variables pour les trois caractéristiques sont calculées {size=5.8, age=2.5, style=4.7}, alors la taille est plus importante pour le que l'âge ou le style.

Différentes métriques d'importance des variables existent, ce qui peut éclairer des experts en ML sur différents aspects des modèles.

W

la sagesse de la foule

l’idée que la moyenne des opinions ou des estimations d’un grand groupe de personnes ("la foule") produit souvent des résultats étonnamment bons. Prenons l'exemple d'un jeu dans lequel les utilisateurs devineront des bonbons emballés dans un grand bocal. Bien que la plupart des individus les suppositions seront inexactes, la moyenne de toutes les suppositions empiriquement avéré être étonnamment proche du nombre réel de des bonbons dans le bocal.

Les ensembles sont l'équivalent logiciel de la sagesse du public. Même si des modèles individuels émettent des prédictions très imprécises, la moyenne des prédictions de nombreux modèles génère souvent de bonnes prédictions. Par exemple, même si une personne arbre de décision peut faire de mauvaises prédictions, La forêt de décision permet souvent d'obtenir de très bonnes prédictions.