На этой странице содержится глоссарий терминов Decision Forests. Чтобы просмотреть все термины глоссария, нажмите здесь .

А

выборка атрибутов

Тактика обучения леса решений , в которой каждое дерево решений при изучении условия учитывает только случайное подмножество возможных признаков . Обычно для каждого узла отбирается различное подмножество функций. Напротив, при обучении дерева решений без выборки атрибутов для каждого узла рассматриваются все возможные функции.

условие совмещения осей

В дереве решений - условие , включающее только один признак . Например, если площадь является объектом, то условием выравнивания по оси является следующее:

area > 200

Сравните с наклонным состоянием .

Б

упаковка в мешки

Метод обучения ансамбля , при котором каждая составляющая модель обучается на случайном подмножестве обучающих примеров , выбранных с заменой . Например, случайный лес — это набор деревьев решений, обученных с помощью мешков.

Термин «бэггинг» является сокращением от бутстрап - агрегирования .

двоичное состояние

В дереве решений — условие , имеющее только два возможных результата, обычно «да» или «нет» . Например, следующее двоичное условие:

temperature >= 100

Сравните с небинарным состоянием .

С

состояние

В дереве решений — любой узел , вычисляющий выражение. Например, следующая часть дерева решений содержит два условия:

Условие также называется разделением или проверкой.

Контрастное состояние с листом .

См. также:

Д

лес решений

Модель, созданная из нескольких деревьев решений . Лес решений делает прогноз путем агрегирования прогнозов своих деревьев решений. Популярные типы лесов решений включают случайные леса и деревья с градиентным усилением .

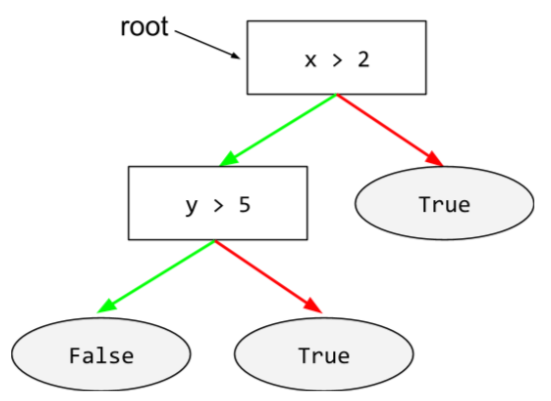

дерево решений

Модель контролируемого обучения, состоящая из набора условий и листьев, организованных иерархически. Например, следующее дерево решений:

Э

энтропия

В теории информации — описание того, насколько непредсказуемо распределение вероятностей. Альтернативно, энтропия также определяется как количество информации, содержащейся в каждом примере . Распределение имеет максимально возможную энтропию, когда все значения случайной величины равновероятны.

Энтропия набора с двумя возможными значениями «0» и «1» (например, метки в задаче бинарной классификации ) имеет следующую формулу:

H = -p log p - q log q = -p log p - (1-p) * log (1-p)

где:

- H — энтропия.

- p — доля примеров «1».

- q — доля примеров «0». Обратите внимание, что q = (1 - p)

- log обычно равен log 2 . В данном случае единицей энтропии является бит.

Например, предположим следующее:

- 100 примеров содержат значение «1»

- 300 примеров содержат значение «0»

Следовательно, значение энтропии равно:

- р = 0,25

- q = 0,75

- H = (-0,25)log 2 (0,25) - (0,75)log 2 (0,75) = 0,81 бит на пример

Идеально сбалансированный набор (например, 200 «0» и 200 «1») будет иметь энтропию 1,0 бита на каждый пример. Когда набор становится более несбалансированным , его энтропия приближается к 0,0.

В деревьях решений энтропия помогает сформулировать прирост информации , чтобы помочь разделителю выбрать условия во время роста дерева решений классификации.

Сравните энтропию с:

- Джини примесь

- функция перекрестных энтропийных потерь

Энтропию часто называют энтропией Шеннона.

Ф

важность функций

Синоним переменных важностей .

Г

Джини примесь

Метрика, похожая на энтропию . Разделители используют значения, полученные либо из примеси Джини, либо из энтропии, для составления условий для деревьев решений классификации. Прирост информации происходит от энтропии. Не существует общепринятого эквивалентного термина для показателя, полученного из примеси Джини; однако этот безымянный показатель так же важен, как и получение информации.

Примесь Джини еще называют индексом Джини , или просто Джини .

Деревья решений (GBT) с градиентным усилением

Тип леса решений , в котором:

- Обучение основано на повышении градиента .

- Слабая модель — это дерево решений .

повышение градиента

Алгоритм обучения, в котором слабые модели обучаются для итеративного улучшения качества (уменьшения потерь) сильной модели. Например, слабая модель может представлять собой линейную модель или модель небольшого дерева решений. Сильная модель становится суммой всех ранее обученных слабых моделей.

В простейшей форме повышения градиента на каждой итерации слабая модель обучается прогнозированию градиента потерь сильной модели. Затем выходные данные сильной модели обновляются путем вычитания прогнозируемого градиента, аналогично градиентному спуску .

где:

- $F_{0}$ — стартовая сильная модель.

- $F_{i+1}$ — следующая сильная модель.

- $F_{i}$ — текущая сильная модель.

- $\xi$ — это значение от 0,0 до 1,0, называемое сжатием , которое аналогично скорости обучения при градиентном спуске.

- $f_{i}$ — слабая модель, обученная прогнозировать градиент потерь $F_{i}$.

Современные варианты повышения градиента также включают в свои вычисления вторую производную (гессиан) потерь.

Деревья решений обычно используются в качестве слабых моделей при повышении градиента. См. деревья (решения) с градиентным усилением .

я

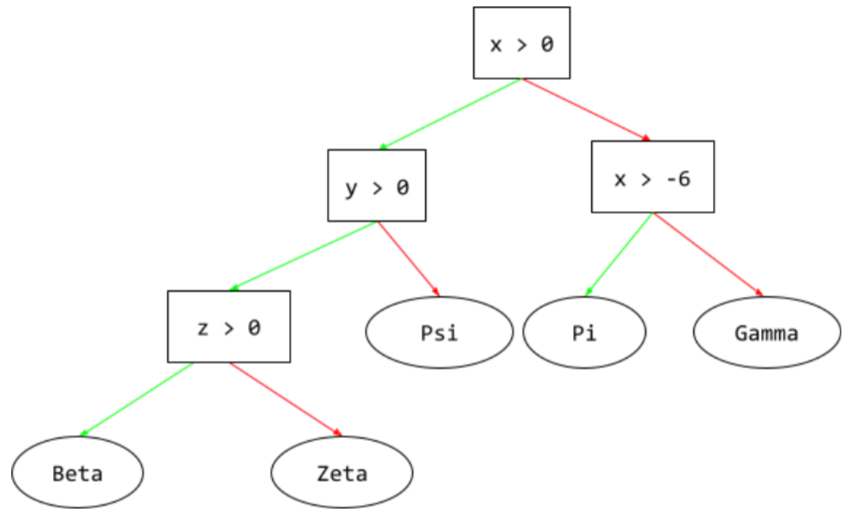

путь вывода

В дереве решений во время вывода маршрут конкретного примера проходит от корня к другим условиям , заканчиваясь листом . Например, в следующем дереве решений более толстые стрелки показывают путь вывода для примера со следующими значениями функций:

- х = 7

- у = 12

- г = -3

Путь вывода на следующей иллюстрации проходит через три состояния, прежде чем достичь листа ( Zeta ).

Три толстые стрелки показывают путь вывода.

получение информации

В лесах решений — разница между энтропией узла и взвешенной (по количеству примеров) суммой энтропии его дочерних узлов. Энтропия узла — это энтропия примеров в этом узле.

Например, рассмотрим следующие значения энтропии:

- энтропия родительского узла = 0,6

- энтропия одного дочернего узла с 16 соответствующими примерами = 0,2

- энтропия другого дочернего узла с 24 соответствующими примерами = 0,1

Таким образом, 40% примеров находятся в одном дочернем узле, а 60% — в другом дочернем узле. Поэтому:

- взвешенная сумма энтропии дочерних узлов = (0,4 * 0,2) + (0,6 * 0,1) = 0,14

Итак, информационный выигрыш составляет:

- Прирост информации = энтропия родительского узла - взвешенная сумма энтропии дочерних узлов

- прирост информации = 0,6 - 0,14 = 0,46

Большинство раскольников стремятся создать условия , которые максимизируют получение информации.

в установленном состоянии

В дереве решений — условие , проверяющее наличие одного элемента в наборе элементов. Например, следующее является встроенным условием:

house-style in [tudor, colonial, cape]

Во время вывода, если значением признака стиля дома является tudor , colonial или cape , тогда это условие оценивается как Да. Если значение признака стиля дома другое (например, ranch ), то это условие оценивается как Нет.

Условия в наборе обычно приводят к более эффективным деревьям решений, чем условия, которые проверяют функции горячего кодирования .

л

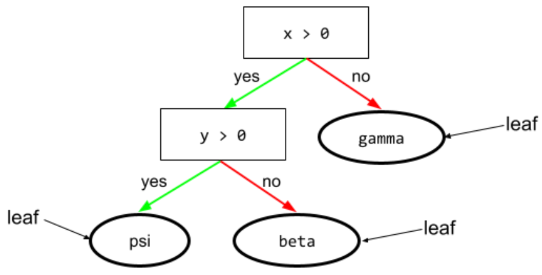

лист

Любая конечная точка в дереве решений . В отличие от условия , лист не выполняет проверку. Скорее, лист – возможное предсказание. Лист также является конечным узлом пути вывода .

Например, следующее дерево решений содержит три листа:

Н

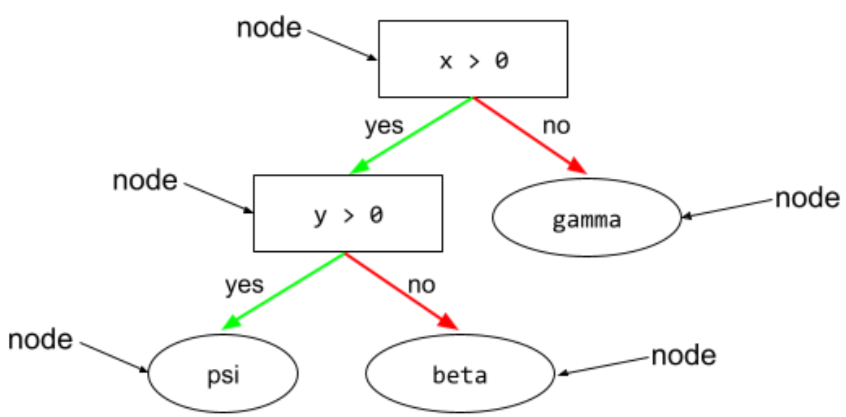

узел (дерево решений)

В дереве решений любое условие или лист .

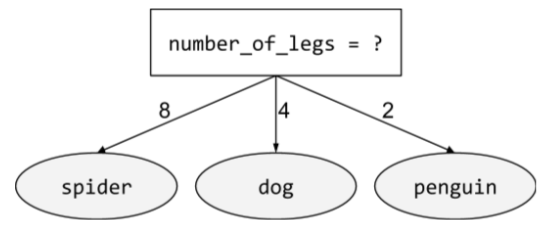

небинарное состояние

Условие , содержащее более двух возможных исходов. Например, следующее небинарное условие содержит три возможных результата:

О

косое состояние

В дереве решений - условие , включающее более одного признака . Например, если высота и ширина являются объектами, то следующее условие является наклонным:

height > width

Контраст с условием выравнивания по оси .

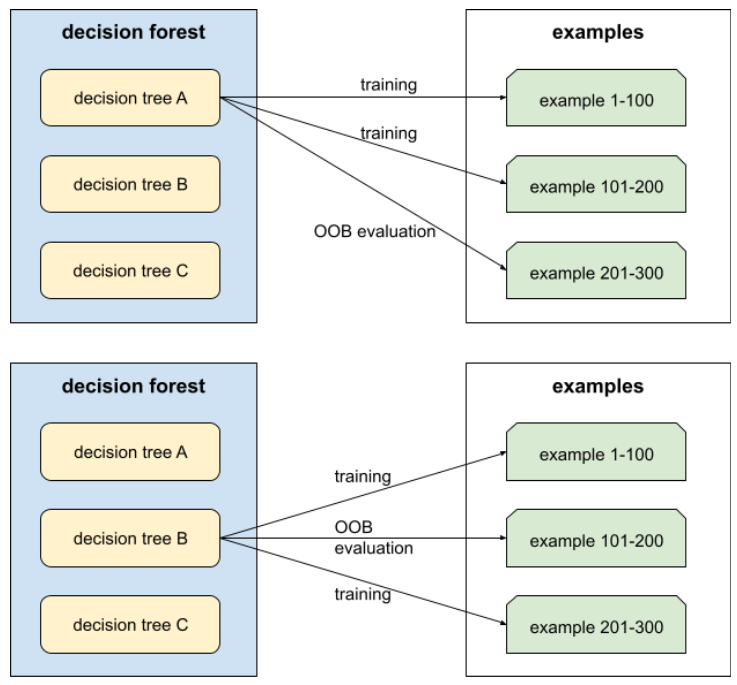

предварительная оценка (оценка OOB)

Механизм оценки качества леса решений путем тестирования каждого дерева решений на примерах , не использованных во время обучения этого дерева решений. Например, на следующей диаграмме обратите внимание, что система обучает каждое дерево решений примерно на двух третях примеров, а затем сравнивает его с оставшейся одной третью примеров.

Оценка вне пакета — это вычислительно эффективная и консервативная аппроксимация механизма перекрестной проверки . При перекрестной проверке одна модель обучается для каждого раунда перекрестной проверки (например, 10 моделей обучаются при 10-кратной перекрестной проверке). При оценке OOB обучается одна модель. Поскольку пакетирование удерживает некоторые данные из каждого дерева во время обучения, внесистемная оценка может использовать эти данные для аппроксимации перекрестной проверки.

П

Значения переменных перестановки

Тип важности переменной , которая оценивает увеличение ошибки прогнозирования модели после перестановки значений признака. Важность переменной перестановки — это метрика, независимая от модели.

Р

случайный лес

Ансамбль деревьев решений , в котором каждое дерево решений обучается с использованием определенного случайного шума, такого как пакетирование .

Случайные леса — это тип леса решений .

корень

Начальный узел (первое условие ) в дереве решений . По соглашению, корень диаграммы располагается на вершине дерева решений. Например:

С

выборка с заменой

Метод выбора элементов из набора элементов-кандидатов, при котором один и тот же элемент может быть выбран несколько раз. Фраза «с заменой» означает, что после каждого выбора выбранный элемент возвращается в пул элементов-кандидатов. Обратный метод — выборка без замены — означает, что элемент-кандидат можно выбрать только один раз.

Например, рассмотрим следующий набор фруктов:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Предположим, что система случайным образом выбирает fig в качестве первого элемента. Если используется выборка с заменой, то система выбирает второй элемент из следующего набора:

fruit = {kiwi, apple, pear, fig, cherry, lime, mango}

Да, это тот же набор, что и раньше, поэтому система потенциально может снова выбрать fig .

Если используется отбор проб без замены, после отбора образец не может быть взят повторно. Например, если система случайным образом выберет fig в качестве первого образца, то fig нельзя будет выбрать еще раз. Поэтому система выбирает вторую выборку из следующего (сокращенного) набора:

fruit = {kiwi, apple, pear, cherry, lime, mango}

усадка

Гиперпараметр в повышении градиента , который контролирует переобучение . Сокращение при повышении градиента аналогично скорости обучения при градиентном спуске . Усадка — это десятичное значение от 0,0 до 1,0. Более низкое значение усадки уменьшает переобучение больше, чем большее значение усадки.

расколоть

В дереве решений другое название условия .

разделитель

При обучении дерева решений — процедура (и алгоритм), отвечающая за поиск наилучшего состояния в каждом узле .

Т

тест

В дереве решений другое название условия .

порог (для деревьев решений)

В состоянии выравнивания по оси — значение, с которым сравнивается объект . Например, 75 — это пороговое значение в следующем условии:

grade >= 75

В

переменные значения

Набор оценок, указывающий относительную важность каждой функции для модели.

Например, рассмотрим дерево решений , которое оценивает цены на жилье. Предположим, что в этом дереве решений используются три характеристики: размер, возраст и стиль. Если набор важностей переменных для трех признаков рассчитан как {size=5,8, age=2,5, style=4,7}, то размер более важен для дерева решений, чем возраст или стиль.

Существуют различные метрики важности переменных, которые могут информировать экспертов по машинному обучению о различных аспектах моделей.

Вт

мудрость толпы

Идея о том, что усреднение мнений или оценок большой группы людей («толпы») часто дает удивительно хорошие результаты. Например, рассмотрим игру, в которой люди угадывают количество жевательных конфет, упакованных в большую банку. Хотя большинство индивидуальных предположений будут неточными, эмпирически было показано, что среднее значение всех догадок удивительно близко к фактическому количеству мармеладных конфет в банке.

Ансамбли — это программный аналог мудрости толпы. Даже если отдельные модели дают крайне неточные прогнозы, усреднение прогнозов многих моделей часто дает удивительно хорошие прогнозы. Например, хотя отдельное дерево решений может давать плохие прогнозы, лес решений часто дает очень хорошие прогнозы.