הדף הזה מכיל מונחים ממילון המונחים של הערכת השפה. לכל המונחים במילון המונחים, יש ללחוץ כאן.

A

תשומת הלב,

מנגנון שנמצא בשימוש ברשת נוירונים ומציין החשיבות של מילה מסוימת או חלק ממילה מסוימת. דחיסת נתונים כמות המידע שנדרש למודל כדי לחזות את האסימון/המילה הבאה. מנגנון תשומת לב טיפוסי עשוי לכלול סכום משוקלל בקבוצה של ערכי קלט, כאשר משקל לכל קלט מחושב על ידי חלק אחר רשת זרימה קדימה.

כדאי גם להשתמש בקשב עצמי הקשב העצמי עם מספר ראשים, אבני הבניין של טרנספורמרים.

מקודד אוטומטי

מערכת שלומדת לחלץ את המידע החשוב ביותר מהקלט. מקודדים אוטומטיים הם שילוב של מקודד מפענח. מקודדים אוטומטיים מסתמכים על התהליך הבא שכולל שני שלבים:

- המקודד ממפה את הקלט לפורמט דו-ממדי נמוך יותר (בדרך כלל) (בינוני).

- המפענח בונה גרסת איבוד נתונים של הקלט המקורי על ידי מיפוי מהפורמט של ממדים נמוכים יותר לפורמט המקורי עם ממדים גבוהים יותר בפורמט הקלט.

המקודדים האוטומטיים מאומנים מקצה לקצה כי המפענח מנסה לעשות לשחזר את הקלט המקורי מפורמט הביניים של המקודד ככל האפשר. כי פורמט הביניים קטן יותר (בממד נמוך יותר) מהפורמט המקורי, המקודד האוטומטי מאולץ ללמוד איזה מידע בקלט הוא חיוני, והפלט יהיה זהה לחלוטין לקלט.

לדוגמה:

- אם נתוני הקלט הם גרפיים, העותק הלא מדויק יהיה דומה ל- את הגרפיקה המקורית, אבל שונתה במידה מסוימת. אולי עותק לא מדויק מסיר את הרעש מהגרפיקה המקורית או ממלא את חסרים כמה פיקסלים.

- אם נתוני הקלט הם טקסט, מקודד אוטומטי ייצור טקסט חדש שמחקה (אבל לא זהה) לטקסט המקורי.

מידע נוסף זמין גם במאמר מקודדים אוטומטיים משתנים.

מודל רגרסיבי אוטומטי

מודל שמסיק חיזוי על סמך הנתונים הקודמים שלו ויצירת חיזויים. לדוגמה, מודלים רגרסיביים של שפה חוזים האסימון על סמך האסימונים שצפויים בעבר. כל המודלים שמבוססים על Transformer מודלים גדולים של שפה (LLM) הם רגרסיביים אוטומטית.

לעומת זאת, מודלים של תמונה מבוססי GAN בדרך כלל לא רגרסיביים אוטומטית. כי הם יוצרים תמונה במעבר אחד ולא באופן איטרטיבי לבצע מיליון שלבים. עם זאת, חלק מהמודלים ליצירת תמונות הם רגרסיביים אוטומטית כי הם יוצרים תמונה בשלבים.

B

שק מילים

ייצוג של המילים בביטוי או בקטע, ללא קשר לסדר שבו הם מופיעים. לדוגמה, 'שק מילים' מייצג את הבאים באופן זהה:

- הכלב קופץ

- מקפץ את הכלב

- כלב קופץ

כל מילה ממופה לאינדקס בוקטור דליל, שבו לווקטור יש אינדקס לכל מילה באוצר המילים. לדוגמה, הביטוי הכלב קופץ ממופה לווקטור מאפיין, שהוא לא אפס בשלושת האינדקסים שתואמים למילים the , dog דילוגים. הערך שאינו אפס יכול להיות כל אחת מהאפשרויות הבאות:

- A 1 כדי לציין נוכחות של מילה.

- ספירה של מספר הפעמים שמילה מופיעה בתיק. לדוגמה, אם הביטוי היה "כלב חום" הוא כלב עם פרווה חום ערמוני, אז שניהם חום ערמוני וכלב מיוצגים בתור 2, בעוד שהמילים האחרות צריך להיות מיוצג בתור 1.

- ערך אחר כלשהו, כגון הלוגריתם של מספר פעם שמילה מופיעה בתיק.

BERT (מקודד דו-כיווני ייצוגים מטרנספורמרים)

ארכיטקטורה של מודלים למצג שווא של טקסט. אמנת מודל BERT יכול לשמש כחלק ממודל גדול יותר לסיווג טקסט, למשימות אחרות של למידת מכונה.

ל-BERT יש את המאפיינים הבאים:

- משתמש בארכיטקטורה של Transformer, ולכן הוא מסתמך על קשב עצמי.

- משתמש בחלק המקודד של הטרנספורמר. התפקיד של המקודד היא ליצור ייצוגים טובים של טקסט, במקום לבצע תיאור ספציפי כמו סיווג.

- היא דו-כיוונית.

- נעשה שימוש באנונימיזציה לצורך הדרכה בלתי מונחית.

הווריאציות של BERT כוללות:

ראו Open Sourcing BERT: State-of-the-Art-training for Natural Language בעיבוד לסקירה כללית של BERT.

דו-כיווני

מונח שמשמש לתיאור מערכת שמעריכה את הטקסט שגם מקדים ועוקבת אחרי קטע היעד בטקסט. לעומת זאת, מערכת חד-כיוונית בלבד הפונקציה מחזירה את הטקסט שמקדם את קטע היעד בטקסט.

לדוגמה, נניח שיש לכם מודל התממת שפה (MLM) חייב לקבוע את ההסתברויות למילה או למילים המייצגות את קו תחתון השאלה הבאה:

מה זה _____ איתך?

מודל שפה חד-כיווני צריך לבסס רק את ההסתברויות שלו בהקשר שמספק המילים "מה", "הוא" ו"ה". לעומת זאת, מודל שפה דו-כיווני יכול גם לקבל הקשר מ-"with". ו'את/ה', מה שעשוי לעזור למודל ליצור חיזויים טובים יותר.

מודל שפה דו-כיווני

מודל שפה שקובע את ההסתברות נתון שנמצא במיקום מסוים בקטע של טקסט המבוסס על את הטקסט הקודם והעוקב.

Bigram

N-gram שבו N=2.

BLEU (Bilingual Evaluation Substudy)

ציון בין 0.0 ל-1.0, כולל, שמעיד על איכות התרגום בין שתי שפות אנושיות (לדוגמה, בין אנגלית לרוסית). BLEU ציון של 1.0 מצביע על תרגום מושלם. דירוג BLEU 0.0 מציין תרגום גרוע.

C

מודל שפה סיבתית

מילה נרדפת למודל שפה חד-כיווני.

אפשר לעיין במודל שפה דו-כיווני כדי להבדיל בין גישות כיווניות שונות בבניית מודלים של שפות.

הנחיות בטכניקת שרשרת מחשבה

שיטה של הנדסת הנחיות שמעודדת מודל שפה גדול (LLM) שיסביר את את הסבירות, שלב אחר שלב. לדוגמה, נבחן את ההנחיה הבאה, שימו לב במיוחד למשפט השני:

כמה כוחות ג'י ירגישו הנהג במכונית מ-0 עד 60 מיילים בשעה ב-7 שניות? בתשובה, מציגים את כל החישובים הרלוונטיים.

סביר להניח שהתשובה של ה-LLM:

- הצגת רצף של נוסחאות בפיזיקה, שמחברים את הערכים 0, 60 ו-7 במקומות המתאימים.

- הסבירו למה בחרו בה את הנוסחאות האלה ומה המשמעות של המשתנים השונים.

הנחיות בטכניקת שרשרת מחשבה מאלצות את ה-LLM לבצע את כל החישובים, מה שעלול להוביל לתשובה נכונה יותר. בנוסף, שרשרת מחשבה הנחיה עם תשובה מאפשרת למשתמש לבחון את השלבים של ה-LLM כדי לקבוע או שהתשובה לא הגיונית.

צ'אט, צ'ט, צאט, צט

לתוכן של שיח בין שתי פעימות עם מערכת למידת מכונה, בדרך כלל מודל שפה גדול (LLM). האינטראקציה הקודמת בצ'אט (מה הקלדתם ואיך מודל השפה הגדול (LLM) הגיב) הופך ל- את ההקשר לחלקים הבאים של הצ'אט.

צ'אט בוט הוא אפליקציה של מודל שפה גדול (LLM).

קונבולציה

הזיה היא מילה נרדפת.

מונחה הוא כנראה מדויק יותר מבחינה טכנית מאשר הזיה. עם זאת, תגובות לא תואמות נתונים הפכו לפופולריות לפני כולם.

ניתוח של מחוז בחירה

פיצול משפט למבנים דקדוקיים קטנים יותר ('מרכיבים'). חלק מאוחר יותר במערכת למידת המכונה, כמו של הבנת שפה טבעית, יכול לנתח את המרכיבים בקלות רבה יותר מאשר המשפט המקורי. לדוגמה, נבחן את המשפט הבא:

חבר שלי אימץ שני חתולים.

מנתח של מחוז בחירה יכול לחלק את המשפט הזה כך: שני מרכיבים:

- חבר שלי הוא ביטוי של שם עצם.

- אמץ שני חתולים הוא ביטוי של פועל.

ניתן לחלק את המרכיבים האלה לחלוקות משנה קטנות יותר. לדוגמה, הביטוי של פועל

אימץ שני חתולים

ניתן לחלק אותו לקבוצות משנה:

- adopted הוא פועל.

- שני חתולים הוא ביטוי נוסף של שם עצם.

הטמעת שפה לפי הקשר

הטמעה קרובה ל'הבנה' מילים וביטויים באופן שדוברים ילידיים יכולים לראות. שפה לפי הקשר הטמעות יכולות להבין תחביר, סמנטיקה והקשר מורכבים.

לדוגמה, כדאי לשקול הטמעות של המילה באנגלית cow. הטמעות ישנות יותר כמו word2vec יכול לייצג אנגלית מילים כמו המרחק בשטח ההטמעה מפרה לשור דומה למרחק מכבשה (כבשה) ram (כבש זכר) או מנקבה לזכר. שפה לפי הקשר יכולות להשתפר צעד אחד קדימה, בגלל זיהוי שדוברי אנגלית משתמשים במילה פרה ופירושה "פרה" או "שור".

חלון ההקשר

מספר האסימונים שמודל יכול לעבד הודעה. ככל שחלון ההקשר גדול יותר, כך יש יותר מידע שהמודל יכול להשתמש בהן כדי לספק תשובות עקביות ועקביות להנחיה.

פריחה מקרוסלת

משפט או ביטוי עם משמעות לא ברורה. פריחת הפריחה מהווה בעיה משמעותית בטבע הבנת השפה. לדוגמה, הכותרת Red Tape Holds Up מלבן עומד היא לפריחת התוצאות, מכיוון שמודל NLU יכול לפרש את הכותרת באופן מילולי או באופן בדיוני.

D

מפענח

באופן כללי, כל מערכת למידת מכונה שעוברת המרה ממערכת מעובדת, צפופה או מייצוג פנימי יותר לייצוג גולמי, דל או חיצוני יותר.

מפענחים הם בדרך כלל רכיב במודל גדול יותר, בשילוב עם מקודד.

במשימות של רצף לרצף, מפענח מתחיל במצב הפנימי שהמקודד יצר כדי לחזות את המופע הבא ברצף.

ההגדרה של מפענח בתוך Transformer על הארכיטקטורה של טרנספורמר.

ניקוי רעשים

גישה נפוצה ללמידה בפיקוח עצמי שבו:

ביטול "הפרעות" מאפשר ללמוד מדוגמאות ללא תוויות. מערך הנתונים המקורי משמש כיעד או תווית וגם את הנתונים עם הרעש בתור הקלט.

בחלק מהמודלים המסופים של שפה (MLM) משתמשים בביטול רעשים ככה:

- הוספה של רעש באופן מלאכותי למשפט לא מתויג באמצעות אנונימיזציה של חלק את האסימונים.

- המודל מנסה לחזות את האסימונים המקוריים.

הנחיות ישירות

מילה נרדפת להנחיות מאפס (zero-shot)..

E

עריכת המרחק

מדידה של הדמיון בין שתי מחרוזות טקסט. בלמידת מכונה, עריכת המרחק היא שימושית כי ודרך יעילה להשוות שתי מחרוזות שידועות דומות או למצוא מחרוזות שדומות למחרוזת נתונה.

יש כמה הגדרות של מרחק עריכה, כל אחת מהן משתמשת במחרוזת שונה ב-AI. לדוגמה, מרחק לבנשטיין מביא בחשבון את פעולות המחיקה, הזנה וההחלפה שמצוינות בו הכי פחות.

לדוגמה, המרחק של לבנשטיין בין המילים 'לב' ו'חיצים' הוא 3, כי 3 העריכות הבאות הן השינויים הכי מעטים לביצוע מילה אחת לתוך השני:

- לב ← deart (מחליפים את 'h' ב-'d')

- deart ← dart (Delete "e")

- חץ ← הטלת חיצים (insert "s")

שכבת הטמעה

שכבה נסתרת מיוחדת שמבצעת אימון על תכונה קטגורית בעלת ממדים גבוהים כדי ללמוד בהדרגה את וקטור ההטמעה של מימד נמוך יותר. מאפשרת לרשת נוירונים לאמן הרבה יותר ביעילות רבה יותר מאשר אימונים רק על התכונה קטגורית בממדים גבוהים.

לדוגמה, Google Earth תומך כרגע בכ-73,000 זני עצים. נניח

מין עצים הוא תכונה במודל, לכן

בשכבת הקלט יש וקטור חם אחד 73,000

לאורך זמן.

לדוגמה, אולי baobab מיוצגת בערך כך:

מערך של 73,000 רכיבים הוא ארוך מאוד. אם לא מוסיפים שכבת הטמעה האימון של המודל ידרוש זמן רב מאוד שמכפילה 72,999 אפסים. אולי תבחרו את שכבת ההטמעה שתכיל של 12 מאפיינים. כתוצאה מכך, שכבת ההטמעה תלמד בהדרגה וקטור הטמעה חדש לכל מין של עץ.

במצבים מסוימים, גיבוב הוא חלופה סבירה לשכבת הטמעה.

שטח הטמעה

מרחב וקטורי D-מימדי שמופיע מתוך של שטח וקטורי ממופים. באופן אידיאלי, מרחב ההטמעה מבנה שמוביל לתוצאות מתמטיות משמעותיות; לדוגמה, במרחב הטמעה אידיאלי, חיבור וחיסור של הטמעות יכול לפתור משימות של אנלוגיה מילולית.

המוצר הכולל נקודות של שתי הטמעות הוא מדד של הדמיון ביניהם.

וקטור הטמעה

באופן כללי, מערך של מספרים נקודתיים (floating-point) נלקח מכל דבר מוסתרת שמתארת את מקורות הקלט של השכבה המוסתרת הזו. לעיתים קרובות, וקטור הטמעה הוא מערך של מספרים בנקודה צפה (floating-point) שמאומן או שכבת הטמעה. לדוגמה, נניח ששכבת הטמעה חייבת ללמוד של כל אחד מ-73,000 מינים של עצים בכדור הארץ. אולי המערך הבא הוא וקטור ההטמעה של עץ באובב:

וקטור הטמעה הוא לא קבוצה של מספרים אקראיים. שכבת הטמעה קובע את הערכים האלה באמצעות אימון, בדומה לאופן שבו רשת נוירונים לומדת משקולות אחרות במהלך אימון. כל רכיב הוא דירוג לאורך מאפיין מסוים של מין עצים. איזה שמייצג את סוגי העצים של המאפיין? זה קשה מאוד שבני אדם יקבעו.

החלק המתמטי המתמטי של וקטור הטמעה הוא לפריטים יש קבוצות דומות של מספרי נקודה צפה (floating-point). לדוגמה, לזנים של עצים יש קבוצה דומה יותר של מספרי נקודה צפה (floating-point) בין מיני עצים שונים. עצי סקוויה וסקויה הם זני עצים קשורים, תהיה להם קבוצה דומה יותר של מספרים צפים עצי סקוויה וכף קוקוס. המספרים בווקטור ההטמעה משתנה בכל פעם שמאמנים מחדש את המודל, גם אם מאמנים את המודל מחדש עם קלט זהה.

מקודד

באופן כללי, כל מערכת למידת מכונה שממירה נתונים גולמיים, דליים או חיצוניים לייצוג פנימי יותר, מעובד יותר או צפוף יותר.

מקודדים הם לעיתים קרובות רכיב במודל גדול יותר, מותאם למפענח. חלק מטרנספורמרים מתאימים בין מקודדים למפענחים, אבל טרנספורמרים אחרים משתמשים רק או רק את המפענח.

חלק מהמערכות משתמשות בפלט של המקודד כקלט לסיווג רשת רגרסיה.

במשימות של רצף לרצף, מקודד לוקחת רצף קלט ומחזירה מצב פנימי (וקטור). לאחר מכן, מפענח משתמש במצב הפנימי הזה כדי לחזות את הרצף הבא.

ההגדרה של מקודד מופיעה בקטע Transformer על הארכיטקטורה של טרנספורמר.

F

הנחיות מכמה דוגמאות

הנחיה שמכילה יותר מדוגמה אחת ('מעט') הדגמה של המודל מודל שפה גדול (LLM) צריך להגיב. לדוגמה, ההנחיה הארוכה הבאה מכילה דוגמאות שמראות מודל שפה גדול (LLM) איך לענות על שאילתה.

| החלקים של הנחיה אחת | הערות |

|---|---|

| מה המטבע הרשמי של המדינה שצוינה? | השאלה שעליה יצטרך לענות ה-LLM. |

| צרפת: EUR | דוגמה אחת. |

| בריטניה: GBP | דוגמה נוספת. |

| הודו: | השאילתה עצמה. |

הנחיות מכמה דוגמאות מניבות תוצאות רצויות יותר בדרך כלל הנחיות מאפס (zero-shot) וגם יצירת הנחיות מדוגמה אחת. אבל כדי ליצור הנחיות עם כמה דוגמאות דורש הנחיה ארוכה יותר.

הנחיות מכמה דוגמאות הן סוג של למידה מכמה דוגמאות שהוחל על למידה מבוססת-הנחיות.

כינור

ספריית הגדרה שמתבססת על עדיפות של Python ומגדירה של פונקציות ומחלקות ללא קוד או תשתית פולשניים. במקרה של Pax – ו-codebases אחרים של למידת מכונה – הפונקציות האלה מחלקות מייצגות מודלים ואימון היפר-פרמטרים.

כינור מניחה שבסיסי קוד של למידת מכונה מחולקים בדרך כלל ל:

- קוד הספרייה, שמגדיר את השכבות ואת כלי האופטימיזציה.

- 'דבק' של מערך הנתונים שקורא לספריות ומחבר את הכל יחד.

Fiddle מתעד את מבנה הקריאה של קוד הדבק ניתנת לשינוי.

כוונון עדין

מעבר נוסף של אימון ספציפי למשימה שבוצע מודל שעבר אימון מראש כדי לצמצם את הפרמטרים שלו במקרים ספציפיים. לדוגמה, רצף האימון המלא של חלק מודלים גדולים של שפה (LLM) הם:

- אימון מראש: לאמן מודל שפה גדול (LLM) על מערך נתונים כללי נרחב, כמו כל דפי הוויקיפדיה באנגלית.

- כוונון: מאמנים את המודל שעבר אימון מראש לביצוע משימה ספציפית, למשל, מענה לשאילתות רפואיות. בדרך כלל כוונון עדין מאות או אלפי דוגמאות שמתמקדות במשימה הספציפית.

דוגמה נוספת, רצף האימון המלא של מודל תמונה גדול ככה:

- אימון מראש: אימון מודל תמונה גדול על תמונה כללית גדולה של קבוצת הנתונים, כמו כל התמונות ב-Wikimedia Commons.

- כוונון: מאמנים את המודל שעבר אימון מראש לביצוע משימה ספציפית, כמו יצירת תמונות של אורקות.

כוונון עדין יכול לכלול כל שילוב של השיטות הבאות:

- שינוי כל המודלים הקיימים של המודל שעבר אימון מראש פרמטרים. פעולה זו נקראת לפעמים כוונון עדין.

- שינוי רק חלק מהפרמטרים הקיימים של המודל שעבר אימון מראש (בדרך כלל השכבות הקרובות ביותר לשכבת הפלט), תוך שמירה על שאר הפרמטרים הקיימים ללא שינוי (בדרך כלל השכבות שהכי קרוב לשכבת הקלט). צפייה כוונון יעיל בפרמטרים.

- הוספת שכבות נוספות, בדרך כלל מעל השכבות הקיימות הקרובות ביותר בשכבת פלט.

כוונון עדין הוא סוג של למידת העברה. לכן, כוונון עדין עשוי להשתמש בפונקציית הפסדים שונה או במודל אחר יותר מאלה ששימשו לאימון המודל שעבר אימון מראש. לדוגמה, אפשר: ולכוונן מודל תמונות גדול שעבר אימון מראש כדי ליצור מודל רגרסיה מחזירה את מספר הציפורים בתמונת קלט.

השוו בין כוונון עדין בעזרת המונחים הבאים:

פשתן

קוד פתוח עם ביצועים גבוהים ספרייה עבור למידה עמוקה (Deep Learning) המבוססת על JAX. פלקס מספק פונקציות לצורך אימון רשתות נוירונים, וגם כשיטות להערכת הביצועים.

Flaxformer

Transformer בקוד פתוח ספרייה, מבוסס על Flax, ומיועד בעיקר לעיבוד שפה טבעית (NLP) ומחקר רב-אופני.

G

בינה מלאכותית גנרטיבית

תחום מתפתח ומהנה ללא הגדרה רשמית. עם זאת, רוב המומחים מסכימים שמודלים של בינה מלאכותית גנרטיבית תיצור ('ליצור') תוכן שעונה על כל הקריטריונים הבאים:

- מורכב

- קוהרנטית

- מקורית

לדוגמה, מודל של בינה מלאכותית גנרטיבית יכול ליצור מאמרים או תמונות.

כמה מהטכנולוגיות הקודמות, כולל LSTMs וRNN, יכולות גם ליצור קוהרנטית. חלק מהמומחים מתייחסים לטכנולוגיות הקודמות האלה לגבי בינה מלאכותית גנרטיבית, ואילו אחרים מרגישים שבינה מלאכותית גנרטיבית מסובכת יותר ממה שהטכנולוגיות הקודמות יכולות לייצר.

השוו בין למידת מכונה חזויה.

GPT (טרנספורמר גנרטיבי שעבר אימון מראש)

משפחה שמבוססת על Transformer מודלים גדולים של שפה (LLM) שפותחו על ידי OpenAI.

וריאציות של GPT יכולות לחול על כמה שיטות, כולל:

- יצירת תמונות (לדוגמה, ImageGPT)

- של טקסט לתמונה (לדוגמה, DALL-E).

H

הזיה

הפקת פלט שנראה סביר אבל שגוי עובדתי על ידי של בינה מלאכותית גנרטיבית, שמתיימר ליצור טענות נכונות (assertions) לגבי העולם האמיתי. לדוגמה, מודל של בינה מלאכותית גנרטיבית שטוען שברק אובמה מת בשנת 1865 יש תגובה חיובית.

I

למידה בהקשר

מילה נרדפת להנחיות מכמה דוגמאות.

L

LaMDA (מודל שפה לאפליקציות דיאלוג)

מודל שמבוסס על Transformer מודל שפה גדול (LLM) שפותח על ידי Google ושאומן על מערך נתונים גדול של דיאלוג שיכול ליצור תשובות מציאותיות לשיחות.

LaMDA: השיחה פורצת הדרך שלנו הטכנולוגיה מספקת סקירה כללית.

מודל שפה

מודל שמעריך את ההסתברות של אסימון או רצף של אסימונים ברצף ארוך יותר.

מודל שפה גדול (LLM)

מונח לא רשמי שאין לו הגדרה מחמירה, שפירושו בדרך כלל למודל שפה שכולל מספר גבוה של פרמטרים. חלק ממודלים גדולים של שפה (LLM) מכילים יותר מ-100 מיליארד פרמטרים.

מרחב לטנטי

מילה נרדפת להטמעת המרחב.

LLM

קיצור של large language model (מודל שפה גדול).

LoRA

קיצור של Adaptability בדירוג נמוך.

יכולת התאמה לדירוג נמוך (LoRA)

אלגוריתם לביצוע כוונון יעיל בפרמטרים כוונון עדין רק חלק של פרמטרים של מודל שפה גדול (LLM). LoRA מספק את היתרונות הבאים:

- ההתאמה מתבצעת מהר יותר מאשר שיטות שמצריכות כוונון עדין של כל המאפיינים .

- הפחתת העלות החישובית של הסקה שעבר כוונון עדין.

מודל שמכוונן באמצעות LoRA שומר או משפר את האיכות של החיזויים.

LoRA מאפשר להפעיל כמה גרסאות מיוחדות של המודל.

M

מודל התממת שפה (MLM)

מודל שפה שחוזה את ההסתברות אסימונים נדרשים כדי למלא את החלקים הריקים ברצף. לדוגמה, מודל התממת שפה(MLM) יכול לחשב הסתברויות למילים מועמדות כדי להחליף את הקו התחתון במשפט הבא:

ה-____ בכובע חזר.

בדרך כלל נעשה שימוש במחרוזת "MASK" במקום להוסיף קו תחתון. לדוגמה:

ה-"MASK" חזר.

רוב המודלים המודרניים של שפה מתמשכת הם דו-כיווניים.

מטא-למידה

קבוצת משנה של למידת מכונה שחוקרת או משפרת אלגוריתם של למידה. מערכת מטא-למידה יכולה גם לכוון לאמן מודל כדי ללמוד במהירות כמות קטנה של נתונים או מניסיון שהצטבר במשימות קודמות. אלגוריתמים של מטא-למידה בדרך כלל מנסים להשיג את המטרות הבאות:

- לשפר או ללמוד תכונות שפותחו ביד (כמו מאתחל או כלי אופטימיזציה).

- ייעול הנתונים וייעול המחשוב.

- שיפור ההכללה.

מטא-למידה קשורה ללמידה מסוימת (few-shot).

מודל עזר

קטגוריית נתונים ברמה גבוהה. לדוגמה, מספרים, טקסט, תמונות, וידאו של אודיו יש חמש שיטות שונות.

מקביליות של מודל

דרך לאמן או הסקת מסקנות, שמשלבת חלקים שונים של תהליך את המודל במכשירים שונים. מקבילות של מודל מאפשר למודלים שגדולים מדי מכדי להתאים למכשיר יחיד.

כדי ליישם מקבילות של מודל, מערכת בדרך כלל מבצעת את הפעולות הבאות:

- פיצול (חלקי) של המודל לחלקים קטנים יותר.

- מחלק את האימון של החלקים הקטנים האלה בין מספר מעבדים. כל מעבד מאמן את החלק שלו במודל.

- משלבת את התוצאות כדי ליצור מודל אחד.

המקבילות בין מודלים מאטה את האימון.

ניתן לראות גם מקבילות של נתונים.

קשב עצמי עם מספר ראשים

תוסף של קשב עצמי שמחיל את מנגנון תשומת הלב כמה פעמים לכל מיקום ברצף הקלט.

טרנספורמרים מאפשרים עכשיו קשב עצמי עם מספר ראשים.

מודל רב-אופני

מודל שהקלט ו/או הפלט שלו כוללים יותר מאפשרות אחת מודל השיוך. לדוגמה, נבחן מודל שמקבל גם תמונה וכיתוב טקסט (בשני שיטות) כתכונות, מפיק ציון שמציין עד כמה כיתוב הטקסט מתאים לתמונה. כך שהקלטים במודל הזה הם רב-אופניים והפלט הוא לא-מודאלי.

לא

הבנת שפה טבעית (NLU)

קביעת כוונת המשתמש על סמך מה שהוא הקליד או אמר. לדוגמה, מנוע חיפוש משתמש בהבנת שפה טבעית (NLP) לקבוע מה המשתמש מחפש על סמך מה שהוא הקליד או אמר.

N-gram

רצף סדור של N מילים. לדוגמה, truly madly – 2 גרם. כי נראה רלוונטי, בזהירות! הוא שונה מ-2 גרם באמת בטירוף.

| לא | שמות של N-gram מהסוג הזה | דוגמאות |

|---|---|---|

| 2 | Bigram או 2 גרם | לצאת, ללכת, לאכול ארוחת צהריים, לאכול ארוחת ערב |

| 3 | טריגרם או 3 גרם | אכלתם יותר מדי, שלושה עכברים עיוורים, האגרות בכביש |

| 4 | 4 גרם | ללכת בפארק, אבק ברוח, הילד אכל עדשים |

הרבה הבנת שפה טבעית מודלים מסתמכים על מילי-גרם כדי לחזות את המילה הבאה שהמשתמש יקליד או שאומרים. לדוגמה, נניח שמשתמש הקליד שלושת עיוורים. מודל NLU שמבוסס על טריגרמים יחזה ככל הנראה המשתמש יקיש את המילה עכברים.

בצעו השוואה בין גרם N עם שקיות מילים, שהן קבוצות של מילים לא מסודרות.

NLU

קיצור של שפה טבעית ההבנה.

O

יצירת הנחיות מדוגמה אחת

הנחיה שמכילה דוגמה אחת שממחישה איך מודל שפה גדול (LLM) אמור להגיב. לדוגמה, בהנחיה הבאה יש דוגמה אחת שממחישה מודל שפה גדול הוא אמור לענות על שאילתה.

| החלקים של הנחיה אחת | הערות |

|---|---|

| מה המטבע הרשמי של המדינה שצוינה? | השאלה שעליה יצטרך לענות ה-LLM. |

| צרפת: EUR | דוגמה אחת. |

| הודו: | השאילתה עצמה. |

אתם יכולים להשוות בין הנחיות מדוגמה אחת לבין המונחים הבאים:

P

כוונון יעיל בפרמטרים

סדרת שיטות לכוונון של תמונה מודל שפה שעבר אימון מראש (PLM) בצורה יעילה יותר מאשר כוונון עדין מלא. יעיל בפרמטרים כוונון עדין בדרך כלל מצמצם הרבה יותר פרמטרים מאשר כמות מלאה של כוונון עדין, אבל באופן כללי מוביל מודל שפה גדול (LLM) שמבצע וגם (או כמעט באותה מידה) כמו מודל שפה גדול (LLM) שמבוסס על בכוונון עדין.

השוו והבדילו בין כוונון יעיל בפרמטרים לבין:

כוונון יעיל בפרמטרים נקרא גם כוונון יעיל בפרמטרים.

צינור עיבוד נתונים

צורה של מקבילות של מודל שבה מודל העיבוד מחולק לשלבים רצופים, וכל שלב מתבצע במכשיר אחר. בזמן ששלב אחד מעבד אצווה אחת, בשלב הבא יכול לפעול באצווה הבאה.

למידע נוסף, ראו הדרכה מדורגת.

PLM

קיצור של מודל שפה שעבר אימון מראש.

קידוד תלוי מיקום

שיטה להוספת מידע על המיקום של אסימון ברצף כדי של האסימון. מודלים של טרנספורמרים משתמשים לפי מיקום כדי להבין טוב יותר את הקשר בין חלקים שונים של המודל ברצף.

הטמעה נפוצה של קידוד מבוסס-מיקום משתמשת בפונקציה סינוסאידלית. (באופן ספציפי, התדר והמשרעת של הפונקציה הסינוסאידלית נקבע לפי המיקום של האסימון ברצף.) השיטה הזו שמאפשר למודל טרנספורמר ללמוד לחקור חלקים שונים על סמך המיקום שלהם.

מודל שעבר אימון מראש

של מודלים או רכיבי מודל (כמו וקטור הטמעה) שכבר אומנו. לפעמים תזינו וקטורים של הטמעה שאומנו מראש לתוך רשת נוירונים. במקרים אחרים, המודל יאמן את של ההטמעה עצמה, במקום להסתמך על ההטמעות שאומנו מראש.

המונח מודל שפה שעבר אימון מראש מתייחס מודל שפה גדול (LLM) שעבר אימון מראש.

אימון מראש

אימון ראשוני של מודל על מערך נתונים גדול. חלק מהמודלים שאומנו מראש הם ענקיים מגושמים, ובדרך כלל צריך לטפח אותם באמצעות אימון נוסף. לדוגמה, מומחי למידת מכונה עשויים לאמן מראש מודל שפה גדול (LLM) במערך נתונים גדול של טקסט, כמו כל הדפים באנגלית בוויקיפדיה. לאחר אימון מראש, של המודל שנוצר, אפשר לחדד עוד יותר את שיטות:

הצעה לפעולה

כל טקסט שהוזן כקלט למודל שפה גדול (LLM) כדי להתנות את המודל כך שיתנהג באופן מסוים. ההנחיות יכולות להיות קצרות כמו לביטוי או ארוך באופן שרירותי (לדוגמה, כל הטקסט של רומן). הנחיות נכללות במספר קטגוריות, כולל אלו שמוצגות בטבלה הבאה:

| קטגוריית ההנחיות | דוגמה | הערות |

|---|---|---|

| שאלה | באיזו מהירות יונה יכולה לעוף? | |

| הוראות | כתיבת שיר מצחיק על ארביטראז'. | הנחיה שמבקשת ממודל השפה הגדול (LLM) לבצע פעולה. |

| דוגמה | תרגום של קוד Markdown ל-HTML. מוצרים לדוגמה:

Markdown: * פריט ברשימה HTML: <ul> <li>פריט ברשימה</li> </ul> |

המשפט הראשון בהנחיה הזו לדוגמה הוא הוראה. שאר ההנחיה היא דוגמה. |

| התפקיד | להסביר למה ירידה הדרגתית משמשת באימון של למידת מכונה כדי דוקטור בפיזיקה. | החלק הראשון של המשפט הוא הוראה. את הביטוי "לתואר דוקטור בפיזיקה" הוא החלק של התפקיד. |

| קלט חלקי שיש למודל כדי להשלים | ראש ממשלת בריטניה גר ב- | הנחיה עם קלט חלקי יכולה להסתיים בפתאומיות (כפי שמתרחש בדוגמה הזו) או מסתיימת בקו תחתון. |

מודל בינה מלאכותית גנרטיבית יכול לתת תשובות להנחיה באמצעות טקסט, קוד, תמונות, הטמעות, סרטונים... כמעט הכול.

למידה מבוססת-הנחיות

יכולת של מודלים מסוימים שמאפשרים להם להתאים את עצמם ההתנהגות שלהם בתגובה לקלט טקסט שרירותי (הנחיות). בפרדיגמה טיפוסית של למידה המבוססת על הנחיות, מודל שפה גדול (LLM) משיב להנחיה באמצעות יצירת טקסט. לדוגמה, נניח שמשתמש מזין את ההנחיה הבאה:

סכם את חוק התנועה השלישי של ניוטון.

מודל שמסוגל ללמידה מבוססת-הנחיות לא אומן באופן ספציפי לענות על להנחיה הקודמת. במקום זאת, המודל "יודע" הרבה עובדות על פיזיקה, הרבה על כללי שפה כלליים, והרבה על מה שמכונה באופן כללי לתשובות שימושיות. הידע הזה מספיק כדי לספק תשובה. משוב אנושי נוסף ("התשובה הזו הייתה מורכבת מדי". או "מהי תגובה?") מאפשר למערכות למידה מסוימות שמבוססות על הנחיות לשפר את התועלת של התשובות שלהם.

עיצוב הנחיות

מילה נרדפת להנדסת הנחיות.

הנדסת הנחיות

אומנות יצירת הנחיות שגורמות לתשובות הרצויות ממודל שפה גדול (LLM). בני אדם מבצעים הנחיות של בינה מלאכותית גנרטיבית. כדי לוודא שכתיבת הנחיות מנוסחות היטב היא לקבל תשובות מועילות ממודל שפה גדול. הנדסת פרומפטים תלויה גורמים רבים, כולל:

- מערך הנתונים שמשמש לאימון מקדים ואולי גם משמש לחדד את מודל השפה הגדול (LLM).

- את הטמפרטורה ופרמטרים אחרים של פענוח ליצירת תשובות.

צפייה מבוא לעיצוב הנחיות אפשר לקבל פרטים נוספים על כתיבת הנחיות מועילות.

עיצוב פרומפטים הוא שם נרדף להנדסת פרומפטים.

כוונון של הנחיות

מנגנון כוונון יעיל בפרמטרים שלומדת 'קידומת' שהמערכת מוסיפה הנחיה בפועל.

וריאציה אחת של כוונון של הנחיות – שלפעמים נקראת כוונון תחילית – להוסיף את התחילית בכל שכבה. לעומת זאת, רוב ההנחיות (כוונון) מוסיף קידומת לשכבת הקלט.

R

הנחיות ליצירת תפקידים

חלק אופציונלי בהנחיה שמזהה קהל יעד לתשובה מהמודל בינה מלאכותית גנרטיבית. בלי תפקיד מודל שפה גדול (LLM) מספק תשובה שיכולה להיות מועילה לאדם ששואל את השאלות. עם הנחיה לתפקיד, יכול לענות באופן מתאים ומועיל יותר קהל יעד ספציפי. לדוגמה, החלק של הנחיית התפקיד ההנחיות מופיעות בגופן מודגש:

- לסכם את המאמר הזה לדוקטורט בכלכלה.

- לתאר את האופן שבו גאות ושפל פועלות לגיל עשר.

- הסבירו את המשבר הפיננסי ב-2008. דברו אל ילד קטן, או גולדן רטריבר.

S

קשב עצמי (שכבת הקשב העצמי)

שכבת רשת נוירונים שמשנה רצף הטמעות (למשל, הטמעות אסימון) לרצף נוסף של הטמעות. כל הטמעה ברצף הפלט שנוצר על ידי שילוב מידע מהאלמנטים של רצף הקלט באמצעות מנגנון הפניית תשומת הלב.

החלק עצמי בהקשב העצמי מתייחס לרצף עצמו, ולא בהקשר אחר. אחד מעיקרי הקשב העצמי אבני בניין של טרנספורמרים ומשתמשת בחיפוש מילונים מונחים כמו "query", "key" ו-"value".

שכבת הקשב העצמי מתחילה ברצף של ייצוגי קלט, לכל מילה. ייצוג הקלט של מילה יכול להיות הטמעה אוטומטית. לכל מילה ברצף קלט, הרשת מציין את הרלוונטיות של המילה לכל רכיב ברצף של ולא של מילים בודדות, ציוני הרלוונטיות קובעים את מידת הייצוג הסופי של המילה שמבוסס על הייצוגים של מילים אחרות.

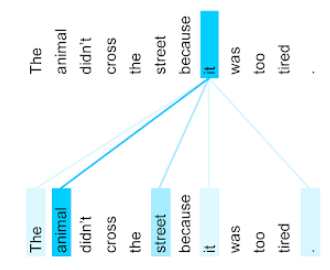

למשל, נבחן את המשפט הבא:

בעל החיים לא חצה את הכביש כי הוא היה עייף מדי.

האיור הבא (מתוך טרנספורמר: ארכיטקטורת רשת נוירונים חדשה לשפה הבנה) שמציג את דפוס תשומת הלב של שכבת הקשב העצמי ללשון הפנייה ה, הכהה של כל שורה, שמציין כמה כל מילה תורמת ייצוג ויזואלי:

שכבת הקשב העצמי מדגישה מילים שרלוונטיות למילה 'it'. כאן נוסף לכך, שכבת תשומת הלב למדה להדגיש מילים שהיא עשויה התייחסות, הקצאת המשקל הגבוה ביותר לבעל חיים.

לרצף של n אסימונים, הקשב העצמי משנה רצף של הטמעות n פעמים נפרדות, פעם אחת בכל מיקום ברצף.

עיינו גם בקטעי Attention קשב עצמי עם מספר ראשים.

ניתוח סנטימנט

שימוש באלגוריתמים סטטיסטיים או באלגוריתמים של למידת מכונה כדי לקבוע גישה כוללת - חיובית או שלילית - כלפי שירות, מוצר, ארגון או נושא. לדוגמה, שימוש ב- הבנת שפה טבעית (NLP), אלגוריתם יכול לבצע ניתוח סנטימנטים במשוב הטקסטואלי מקורס באוניברסיטה כדי לקבוע את המידה שבה בדרך כלל אהבו או לא אהבו את הקורס.

משימת רצף לרצף

משימה שממירה רצף קלט של אסימונים לפלט רצף של אסימונים. לדוגמה, שני סוגים פופולריים של רצף לרצף המשימות הן:

- מתרגמים:

- רצף קלט לדוגמה: "אני אוהב אותך".

- רצף פלט לדוגמה: "Je t'aime"

- מענה לשאלות:

- רצף קלט לדוגמה: "Do I need my car in Tel Aviv? "

- רצף פלט לדוגמה: "No. יש להשאיר את הרכב בבית."

skip-gram

n-gram שעשוי להשמיט (או "לדלג") מילים מהמקור כלומר, ייתכן ש-N המילים לא היו סמוכות זה לזה במקור. סמל האפשרויות הנוספות בדיוק, "k-skip-n-gram" הוא n-gram שבו עד k מילים יכולות להיות בוצע דילוג.

לדוגמה, "השועל החום המהיר" הוא יכול להיות 2 גרם:

- "המהיר"

- "חום מהיר"

- "שועל חום"

A "1-skip-2-gram" הוא שתי מילים שבין מילה אחת לכל היותר. לכן, "השועל החום המהיר" כולל 2 גרם 1-דילוג:

- "חום"

- "שועל מהיר"

בנוסף, כל ה-2 גרם שווה גם 1 גרם ל-2 גרם, כי פחות ניתן לדלג על מילה אחת.

סימני דילוג יכולים לעזור לכם להבין טוב יותר את ההקשר של המילה בסביבה. בדוגמה, "פוקס" היה משויך ישירות למחרוזת בקבוצה של 1-2 גרם, אבל לא בסט של 2 גרם.

אימון עזרה בנושא דילוג על גרם של הטמעת מילים.

כוונון של הנחיות רכות

שיטה לכוונון של מודל שפה גדול (LLM) לביצוע משימה מסוימת, בלי לגזול הרבה משאבים כוונון עדין. במקום לאמן מחדש את כל משקולות במודל, כוונון עדין של הנחיות משנה באופן אוטומטי הנחיה כדי להשיג את אותו יעד.

בתגובה להנחיה טקסטואלית, כוונון עדין של הנחיות בדרך כלל מצרף הטמעות נוספות של אסימונים להנחיה, הפצה לאחור כדי לבצע אופטימיזציה של הקלט.

A "קשה" מכילה אסימונים בפועל במקום הטמעות אסימונים.

פיצ'ר נדיר

תכונה שהערכים שלה הם בעיקר אפס או ריקים. לדוגמה, תכונה שמכילה ערך בודד ומיליון ערכים של 0 מצומצמת. לעומת זאת, לתכונה צפופה יש ערכים הם בעיקר לא אפס או ריקים.

בלמידת מכונה, למספר מפתיע של תכונות יש מעט תכונות. תכונות קטגוריות הן בדרך כלל תכונות מעטות. לדוגמה, מתוך 300 מיני עצים אפשריים ביער, דוגמה אחת יכול לזהות רק עץ אֶדֶר. או מתוך מיליונים של סרטונים אפשריים בספריית הסרטונים, דוגמה אחת עשויה לזהות רק "קזבלנקה".

במודל, בדרך כלל מייצגים תכונות מועטות עם קידוד חם אחד. אם הקידוד החד-פעמי הוא גדול, אפשר להוסיף שכבת הטמעה מעל בקידוד חם אחד ליעילות גבוהה יותר.

ייצוג דל

אחסון רק של המיקומים של אלמנטים שאינם אפס בתכונה מצומצמת.

לדוגמה, נניח שתכונה קטגורית בשם species מזהה את 36

מיני עצים ביער מסוים. בנוסף, מניחים שכל אחד

example מזהה רק מין אחד.

אפשר להשתמש בווקטור לוהט אחד כדי לייצג את מין העצים בכל אחת מהדוגמאות.

וקטור חם אחד יכיל 1 יחיד (לייצוג

את מין העצים הספציפי בדוגמה הזו) ו-35 0s (כדי לייצג

35 זני עצים לא בדוגמה הזו). אז הייצוג החם

של maple עשויים להיראות כך:

לחלופין, ייצוג דליל פשוט יזהה את המיקום של

מינים מסוימים. אם maple נמצא במיקום 24, אז הייצוג הדל

של maple יהיו פשוט:

24

שימו לב שהייצוג הדל הוא הרבה יותר קומפקטי מהייצוג בווקטור יהיה זהה,

אימון מדורג

טקטיקה של אימון מודל ברצף של שלבים נפרדים. היעד יכול להיות כדי לזרז את תהליך האימון או לשפר את איכות המודל.

איור של גישת הסידור בערימה (Progressive Stacking)):

- שלב 1 מכיל 3 שכבות מוסתרות, שלב 2 מכיל 6 שכבות מוסתרות שלב 3 מכיל 12 שכבות מוסתרות.

- שלב 2 מתחיל להתאמן עם המשקולות שנלמדו ב-3 השכבות הנסתרות בשלב 1. שלב 3 מתחיל להתאמן עם המשקולות שנלמדו בשלב השישי של שלב 2.

כדאי לעיין גם בצינור עיבוד נתונים.

אסימון למילת המפתח

ב-language models, אסימון מחרוזת משנה של מילה, שיכולה להיות המילה כולה.

לדוגמה, מילה כמו "itemize" יכול להתפצל לחלקים ש'פריט' (מילת שורש) ו-"ize" (סיומת), כשכל אחת מהן מיוצגת על-ידי ב-Assistant. פיצול של מילים לא נפוצות לקטעים כאלו, שנקראים מילות משנה, מאפשר של המילה לפעול על החלקים שמרכיבים את המילה, כמו תחיליות וסיומות.

לעומת זאת, מילים נפוצות כמו " השינוי הזה" ויכול להיות שהוא שמיוצג על ידי אסימון יחיד.

T

T5

מודל של למידה מטקסט לטקסט נוצר על ידי AI מבית Google ב-2020. T5 הוא מודל מקודד-מפענח, שמבוסס על הארכיטקטורה של Transformer, מאומנות על בסיס של הכיתובים. הוא יעיל במגוון משימות של עיבוד שפה טבעית (NLP), כמו יצירת טקסט, תרגום שפות ומענה על שאלות אופן דיבורי.

השם T5 קיבל את שמו מחמש האותיות T של "Text-to-Text Transfer Transformer".

T5X

מסגרת של למידת מכונה בקוד פתוח, שתוכננה כדי ליצור ולאמן עיבוד רחב של שפה טבעית (NLP) (NLP). T5 מוטמע ב-codebase של T5X (כלומר מבוסס על JAX ו-Flax).

טמפרטורה

היפר-פרמטר ששולט במידת הרנדומיזציה בפלט של המודל. ככל שהטמפרטורות גבוהות יותר, התוצאה תהיה אקראית יותר, וטמפרטורות נמוכות יותר גורמות לפלט אקראי פחות.

בחירת הטמפרטורה הטובה ביותר תלויה באפליקציה הספציפית את המאפיינים המועדפים של הפלט של המודל. לדוגמה, אפשר להעלות את הטמפרטורה ככל הנראה כשיוצרים אפליקציה יוצרת פלט קריאייטיב. לעומת זאת, סביר להניח שהטמפרטורה תהיה נמוכה יותר במהלך הבנייה של מודל שמסווג תמונות או טקסט כדי לשפר את הדיוק והעקביות של המודל.

משתמשים בטמפרטורה לעיתים קרובות בשילוב עם softmax.

טווח הטקסט

טווח האינדקס של המערך המשויך לקטע משנה ספציפי של מחרוזת טקסט.

לדוגמה, המילה good במחרוזת Python s="Be good now" כוללת

הטווח של הטקסט הוא 3 עד 6.

token

במודל שפה, היחידה האטומית שהמודל את האימון ולעשות תחזיות'. בדרך כלל אסימון הוא אחד הבאים:

- מילה אחת – לדוגמה, הביטוי "כלבים כמו חתולים" מורכב משלוש מילים אסימונים: 'כלבים', 'לייק' ו'חתולים'.

- דמות מסוימת, לדוגמה, הביטוי "דג אופניים" מורכב מתשע אסימוני תווים. (חשוב לזכור שהשטח הריק נספר כאחד מהאסימונים).

- מילות משנה – שבהן מילה יחידה יכולה להיות אסימון יחיד או מספר אסימונים. מילת משנה מורכבת ממילה בסיסית, קידומת או סיומת. לדוגמה, שמודל שפה שמשתמש במילות משנה בתור אסימונים עשוי לראות את המילה "כלבים" כשני אסימונים (מילת השורש "כלב" וסיומת הרבים "s"). את אותה יכול לראות את המילה היחידה "גבוהה יותר" כשתי מילות משנה מילת השורש 'גבוה' והסיומת 'er').

בדומיינים מחוץ למודלים של שפה, אסימונים יכולים לייצג סוגים אחרים יחידות אטומיות. לדוגמה, בראייה ממוחשבת, אסימון יכול להיות קבוצת משנה של תמונה.

Transformer

ארכיטקטורת רשת נוירונים שפותחה ב-Google, מסתמכת על מנגנוני קשב עצמי כדי לשנות רצף של הטמעות קלט לרצף של פלט בלי להסתמך על התאמות או רשתות נוירונים חוזרות. טרנספורמר יכול להיות כערימה של שכבות קשב עצמי.

טרנספורמר יכול לכלול כל אחת מהאפשרויות הבאות:

מקודד הופך רצף של הטמעות לרצף חדש של באורך זהה. מקודד כולל N שכבות זהות, שכל אחת מהן מכילה שתי בשכבות המשנה. שתי שכבות המשנה האלה מוחלות בכל מיקום של הקלט של רצף הטמעה, שממירה כל רכיב ברצף הטמעה אוטומטית. שכבת המשנה הראשונה של המקודד צוברת מידע של רצף הקלט. שכבת המשנה השנייה ממירה את את המידע להטמעה של פלט.

מפענח הופך רצף של הטמעות קלט לרצף של הטמעות פלט, שאולי יהיו באורך שונה. מפענח כולל גם N שכבות זהות עם שלוש שכבות משנה, שתיהן דומות ושכבות המשנה של המקודד. שכבת המשנה השלישית של המפענח לוקחת את הפלט והפעילו את מנגנון הקשב העצמי לאסוף ממנו מידע.

בפוסט בבלוג Transformer: A Novel Neural Network Architecture for Language הבנה שהוא מבוא טוב לטרנספורמרים.

טריגר

N-gram שבו N=3.

U

חד-כיווני

מערכת שמעריכה רק את הטקסט שמקדים קטע יעד בטקסט. לעומת זאת, מערכת דו-כיוונית מעריכה טקסט שקודם ועוקב אחרי קטע יעד בטקסט. לקבלת פרטים נוספים, אפשר לעיין בקטע דו-כיווני.

מודל שפה חד-כיווני

מודל שפה שמבסס את ההסתברויות שלו רק על אסימונים שמופיעים לפני, לא אחרי אסימוני היעד. ניגוד למודל שפה דו-כיווני.

V

מקודד אוטומטי וריאציות (VAE)

סוג של מקודד אוטומטי שמנצל את אי-ההתאמה בין קלט לפלט כדי ליצור גרסאות ששונו של הקלט. מקודדים אוטומטיים וריאציוניים (VAE) הם שימושיים לשימוש ב-AI גנרטיבי.

אירועי VEE מבוססים על מסקנות משתנות: שיטה להערכת בפרמטרים של מודל ההסתברות.

W

הטמעת מילים

לייצג כל מילה בקבוצת מילים בתוך embedding vector; כלומר, שמייצג כל מילה בתור וקטור של ערכי נקודה צפה (floating-point) בין 0.0 ל-1.0. מילים עם מילים דומות משמעויות שונות יותר מאשר למילים עם משמעויות שונות. לדוגמה, גזרים, סלרי ומלפפונים נחשבים באופן יחסי של ייצוגים דומים, שיהיו שונים מאוד מהייצוגים של מטוס, משקפי שמש ומשחת שיניים.

Z

יצירת הנחיות מאפס

הנחיה שלא מספקת דוגמה לאופן שבו אתם רוצים מודל השפה הגדול כדי להשיב. לדוגמה:

| החלקים של הנחיה אחת | הערות |

|---|---|

| מה המטבע הרשמי של המדינה שצוינה? | השאלה שעליה יצטרך לענות ה-LLM. |

| הודו: | השאילתה עצמה. |

מודל השפה הגדול (LLM) עשוי להגיב לאחת מהאפשרויות הבאות:

- רופיות

- INR

- ₹

- רופי הודי

- הרופי

- הרופי ההודי

כל התשובות נכונות, אבל יכול להיות שתעדיפו פורמט מסוים.

אתם יכולים להשוות בין הנחיות מאפס לבין המונחים הבאים: