หน้านี้มีคำศัพท์อภิธานศัพท์เกี่ยวกับการประเมินภาษา สำหรับคำศัพท์ในอภิธานศัพท์ทั้งหมด คลิกที่นี่

A

โปรดทราบ

กลไกที่ใช้ในโครงข่ายระบบประสาทเทียมที่ระบุว่า ความสำคัญของคำบางคำหรือส่วนหนึ่งของคำ การบีบอัดโปรดทราบ ปริมาณข้อมูลที่โมเดลต้องการเพื่อคาดการณ์โทเค็น/คำถัดไป กลไกความสนใจโดยทั่วไปอาจประกอบด้วย ผลรวมถ่วงน้ำหนักจากชุดอินพุต โดยที่ฟิลด์ น้ำหนักสำหรับอินพุตแต่ละรายการจะคำนวณโดยส่วนอื่นของ โครงข่ายระบบประสาทเทียม

นอกจากนี้ควรอ่านการใส่ใจตนเองและ multi-head-Attention ซึ่งเป็น องค์ประกอบพื้นฐานของ Transformers

โปรแกรมเปลี่ยนไฟล์อัตโนมัติ

ระบบที่เรียนรู้ที่จะแยกข้อมูลที่สำคัญที่สุดจาก อินพุต โปรแกรมเปลี่ยนไฟล์อัตโนมัติเป็นทั้งโปรแกรมเปลี่ยนไฟล์และ ตัวถอดรหัส โปรแกรมเปลี่ยนไฟล์อัตโนมัติจะใช้กระบวนการ 2 ขั้นตอนต่อไปนี้

- โปรแกรมเปลี่ยนไฟล์จะจับคู่อินพุตกับมิติข้อมูลที่ต่ำกว่า (โดยปกติ) แบบสูญเสียบางส่วน (ระดับกลาง)

- ตัวถอดรหัสจะสร้างอินพุตต้นฉบับในเวอร์ชันแบบสูญเสียบางส่วนด้วยการแมป รูปแบบมิติข้อมูลที่ต่ำกว่าให้เป็นมิติที่สูงขึ้นแบบเดิม รูปแบบอินพุต

โปรแกรมเปลี่ยนไฟล์อัตโนมัติได้รับการฝึกจากต้นทางถึงปลายทางโดยให้เครื่องมือถอดรหัส สร้างอินพุตต้นฉบับจากรูปแบบระดับกลางของโปรแกรมเปลี่ยนไฟล์ ให้ใกล้เคียงที่สุดเท่าที่จะทำได้ เนื่องจากรูปแบบระดับกลางมีขนาดเล็กกว่า (มีมิติต่ำ) กว่ารูปแบบเดิม โปรแกรมเปลี่ยนไฟล์อัตโนมัติจะถูกบังคับให้ เพื่อเรียนรู้ว่าข้อมูลในอินพุตใดที่จำเป็น และเอาต์พุตก็จะไม่ จะเหมือนกับข้อมูลที่ป้อนไว้ทุกประการ

เช่น

- หากข้อมูลที่ป้อนเป็นกราฟิก การคัดลอกที่ไม่ตรงกันทุกประการจะมีลักษณะคล้ายกับ กราฟิกต้นฉบับ แต่มีการแก้ไขบ้าง บางที ข้อความที่ไม่ตรงทั้งหมดจะนำนอยส์ออกจากกราฟิกต้นฉบับหรือเติมแต่ง ไม่มีพิกเซลบางส่วน

- หากข้อมูลอินพุตเป็นข้อความ โปรแกรมเปลี่ยนไฟล์อัตโนมัติจะสร้างข้อความใหม่ที่ เลียนแบบ (แต่ไม่เหมือนกัน) กับข้อความต้นฉบับ

ดูข้อมูลเพิ่มเติมที่โปรแกรมเปลี่ยนไฟล์อัตโนมัติเวอร์ชันต่างๆ

โมเดลถดถอยอัตโนมัติ

โมเดลที่อนุมานการคาดคะเนโดยอิงตามเดิมของโมเดลนี้ การคาดการณ์ เช่น โมเดลภาษาแบบถดถอยอัตโนมัติจะคาดการณ์ โทเค็นตามโทเค็นที่คาดการณ์ไว้ก่อนหน้านี้ แบบ Transformer ทั้งหมด โมเดลภาษาขนาดใหญ่จะถดถอยอัตโนมัติ

ในทางตรงกันข้าม โมเดลรูปภาพที่ใช้ GAN จะไม่ถดถอยโดยอัตโนมัติ เนื่องจากสร้างรูปภาพใน Forward-Pass เดี่ยวและไม่ทำซ้ำใน ขั้นตอน อย่างไรก็ตาม การสร้างรูปภาพบางรูปแบบจะถดถอยโดยอัตโนมัติเนื่องจาก เพื่อสร้างรูปภาพได้เป็นขั้นตอน

B

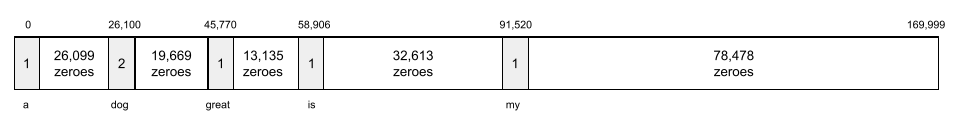

ถุงคำ

การนำเสนอคำในวลีหรือข้อความ โดยไม่คำนึงถึงคำสั่งซื้อ ตัวอย่างเช่น ถุงคำแสดงถึง วลีสามวลีต่อไปนี้เหมือนกันทุกประการ:

- สุนัขกระโดด

- สุนัขกระโดด

- สุนัขกระโดด

แต่ละคำจะแมปกับดัชนีในเวกเตอร์แบบกระจัดกระจาย โดยที่ เวกเตอร์จะมีดัชนีสำหรับทุกคำในคำศัพท์ ตัวอย่างเช่น วลีที่ สุนัขกระโดด จับคู่กับเวกเตอร์จุดสนใจที่ไม่ใช่ 0 ในดัชนีทั้ง 3 รายการที่ตรงกับคำว่า the, dog และ jumps ค่าที่ไม่ใช่ 0 อาจเป็นค่าใดก็ได้ต่อไปนี้

- A 1 เพื่อแสดงการมีอยู่ของคำ

- จำนวนครั้งที่คำปรากฏในกระเป๋า ตัวอย่างเช่น ถ้าวลีคือสุนัขสีแดงเป็นสุนัขที่มีขนสีแดง ทั้งสองคำ น้ำตาลแดง และ สุนัข จะแสดงเป็น 2 ในขณะที่คำอื่นๆ จะแสดงเป็น จะแสดงเป็น 1

- ค่าอื่นๆ เช่น ลอการิทึมของจำนวนของ จำนวนครั้งที่คำปรากฏในกระเป๋า

BERT (โปรแกรมเปลี่ยนไฟล์แบบ 2 ทิศทาง ภาพแทนของ Transformers)

สถาปัตยกรรมโมเดลสำหรับการนําเสนอข้อความ ผู้ที่ได้รับการฝึก โมเดล BERT สามารถทำหน้าที่เป็นส่วนหนึ่งของโมเดลที่ใหญ่กว่าสำหรับการจำแนกประเภทข้อความ หรือ งาน ML อื่นๆ

BERT มีลักษณะเฉพาะดังต่อไปนี้

- ใช้สถาปัตยกรรม Transformer ดังนั้นจึงต้องใช้สถาปัตยกรรม เกี่ยวกับการดึงดูดตนเอง

- ใช้ส่วนโปรแกรมเปลี่ยนไฟล์ของ Transformer งานของโปรแกรมเปลี่ยนไฟล์ คือการสร้างข้อความนำเสนอที่ดี แทนที่จะแสดง อย่างการจำแนกประเภท

- แบบ 2 ทิศทาง

- ใช้การมาสก์เพื่อ การฝึกอบรมที่ไม่มีการควบคุมดูแล

รายละเอียดปลีกย่อยของ BERT ได้แก่

วันที่ดู Open Sourcing BERT: การฝึกอบรมล่วงหน้าที่ทันสมัยสำหรับภาษาธรรมชาติ กำลังประมวลผล เพื่อดูภาพรวมของ BERT

แบบ 2 ทาง

คำที่ใช้อธิบายระบบที่ประเมินข้อความที่อยู่ก่อนหน้า และติดตามส่วนเป้าหมายของข้อความ ในทางกลับกัน ระบบ unidirectional เท่านั้น ประเมินข้อความที่อยู่ก่อนส่วนเป้าหมายของข้อความ

ตัวอย่างเช่น ลองพิจารณาโมเดลภาษามาสก์ที่ ต้องกำหนดความน่าจะเป็นของคำหรือกลุ่มคำที่แทนเส้นใต้ใน คำถามต่อไปนี้

_____ กับคุณคืออะไร

โมเดลภาษาแบบทิศทางเดียวจะต้องกำหนดฐานความน่าจะเป็นเท่านั้น ในบริบทของคำว่า "อะไร" "เป็น" และ "" ในทางตรงกันข้าม โมเดลภาษาแบบ 2 ทิศทางอาจได้รับบริบทจาก "with" เช่นกัน และ "คุณ" ซึ่งอาจช่วยให้โมเดลสร้างการคาดการณ์ที่ดีขึ้นได้

โมเดลภาษาแบบ 2 ทิศทาง

โมเดลภาษาที่กำหนดความน่าจะเป็นที่ โทเค็นที่ระบุปรากฏอยู่ในตำแหน่งที่กำหนดในข้อความที่ตัดตอนมาจากข้อความ ข้อความก่อนหน้าและด้านล่าง

Bigram

N-gram ที่มี N=2

BLEU (การศึกษาด้านการประเมินแบบ 2 ภาษา)

คะแนนจะอยู่ระหว่าง 0.0 ถึง 1.0 ซึ่งแสดงถึงคุณภาพของการแปล ระหว่างภาษามนุษย์ 2 ภาษา (เช่น ระหว่างภาษาอังกฤษและรัสเซีย) BLEU คะแนน 1.0 หมายความว่าคำแปลนั้นสมบูรณ์แบบ คะแนน BLEU ที่ 0.0 แสดงว่า การแปลที่แย่มาก

C

โมเดลภาษาทั่วไป

คำพ้องของ unidirectional Language Model

ดูโมเดลภาษาแบบ 2 ทิศทางเพื่อ เปรียบเทียบความแตกต่างของแนวทางการกำหนดทิศทางต่างๆ ในโมเดลภาษา

การสร้างพรอมต์แบบเชนความคิด

เทคนิควิศวกรรมพรอมต์ที่ส่งเสริม โมเดลภาษาขนาดใหญ่ (LLM) เพื่ออธิบาย การให้เหตุผล ทีละขั้นตอน ตัวอย่างเช่น ลองพิจารณาพรอมต์ต่อไปนี้ การจ่ายเงิน ความสนใจเป็นพิเศษกับประโยคที่สอง:

คนขับจะมีแรงขับเท่าใดในรถที่มีแรงขับจาก 0 ถึง 60 ไมล์ต่อชั่วโมงใน 7 วินาทีใช่ไหม แสดงการคำนวณที่เกี่ยวข้องทั้งหมดในคำตอบ

คำตอบของ LLM น่าจะดังนี้

- แสดงลำดับของสูตรฟิสิกส์ การใส่ค่า 0, 60 และ 7 ในสถานที่ที่เหมาะสม

- อธิบายว่าทำไมมันจึงเลือกสูตรเหล่านั้นและตัวแปรต่างๆ หมายถึงอะไร

การแจ้งเตือนแบบเชนความคิดบังคับให้ LLM ทำการคำนวณทั้งหมด ซึ่งอาจทำให้ได้คำตอบที่ถูกต้องมากขึ้น นอกจากนี้ เครือข่ายความคิด ช่วยให้ผู้ใช้ตรวจสอบขั้นตอนของ LLM เพื่อดูว่า หรือว่าคำตอบนั้นไม่สมเหตุสมผล

แชท

เนื้อหาที่มีการสนทนาโต้ตอบกลับไปกลับมาด้วยระบบ ML มักจะเป็น โมเดลภาษาขนาดใหญ่ การโต้ตอบก่อนหน้าในแชท (สิ่งที่คุณพิมพ์และวิธีการที่โมเดลภาษาขนาดใหญ่ตอบกลับ) จะกลายเป็น บริบทสำหรับส่วนต่อๆ ไปของแชท

แชทบ็อตเป็นแอปพลิเคชันของโมเดลภาษาขนาดใหญ่

การพูดคุย

คำพ้องความหมายของความไม่สมเหตุสมผล

การสับสนอาจเป็นศัพท์เทคนิคที่ถูกต้องกว่าคำไม่สมเหตุสมผล อย่างไรก็ตาม ความไม่สมเหตุสมผลก็ได้รับความนิยมเป็นอย่างแรก

การแยกวิเคราะห์เขตเลือกตั้ง

การแบ่งประโยคออกเป็นโครงสร้างทางไวยากรณ์ที่เล็กลง ("ส่วนประกอบ") ส่วนหลังจากนี้ของระบบ ML เช่น โมเดลความเข้าใจภาษาธรรมชาติ สามารถแยกวิเคราะห์ประชาชนได้ง่ายกว่าประโยคต้นฉบับ ตัวอย่างเช่น ให้พิจารณาประโยคต่อไปนี้

เพื่อนฉันเลี้ยงแมวไว้ 2 ตัว

โปรแกรมแยกวิเคราะห์เขตเลือกตั้งสามารถแบ่งประโยคนี้เป็นประโยคต่อไปนี้ มีองค์ประกอบ 2 ส่วน ได้แก่

- เพื่อนของฉันเป็นคำนาม

- รับเลี้ยงแมวสองตัวเป็นวลีกริยา

สามารถแบ่งเขตเลือกตั้งย่อยออกไปเป็นสภาผู้แทนราษฎรที่เล็กลงได้ เช่น วลีที่มีคำกริยา

รับเลี้ยงแมว 2 ตัว

สามารถแยกย่อยเพิ่มเติมออกเป็น

- adopted คือคำกริยา

- two cats เป็นคำนามอีกวลีหนึ่ง

การฝังภาษาที่มีบริบท

การฝังที่เข้าใกล้ "ความเข้าใจ" คำ และวลีต่างๆ ในแบบที่เจ้าของภาษาพูดได้ ภาษาตามบริบท การฝังสามารถเข้าใจไวยากรณ์ ความหมาย และบริบทที่ซับซ้อนได้

เช่น ลองฝังคำว่า cow ในภาษาอังกฤษ การฝังที่เก่ากว่า เช่น word2vec แสดงถึงภาษาอังกฤษ ในลักษณะที่ระยะห่างในพื้นที่การฝัง จากวัวถึงวัวใกล้เคียงกับระยะทางจากแกะ (แกะตัวเมีย) ถึง แกะ (แกะตัวผู้) หรือจากตัวเมียเป็นตัวผู้ ภาษาตามบริบท การฝังวิดีโออาจก้าวล้ำไปอีกขั้น เพียงตระหนักว่าบางครั้งผู้ใช้ภาษาอังกฤษ ใช้คำว่าวัวแบบสบายๆ เพื่อหมายถึงวัวหรือวัว

หน้าต่างบริบท

จำนวนโทเค็นที่โมเดลประมวลผลได้ใน ข้อความแจ้ง ยิ่งหน้าต่างบริบทมีขนาดใหญ่เท่าใด ข้อมูลก็จะยิ่งมากขึ้นเท่านั้น โมเดลนี้สามารถใช้เพื่อให้คำตอบที่สอดคล้องกันและสอดคล้องกัน ลงในข้อความแจ้ง

ดอกไม้บานขัดข้อง

ประโยคหรือวลีที่มีความหมายกำกวม ดอกไม้บานแตกนำเสนอปัญหาที่สำคัญในเรื่องธรรมชาติ ความเข้าใจด้านภาษา ตัวอย่างเช่น บรรทัดแรกแท่งทรงสูงสีแดงค้างไว้เป็น เกิดข้อขัดข้องเนื่องจากโมเดล NLU อาจตีความบรรทัดแรกได้ตรงตัว หรือ เปรียบเสมือน

D

ตัวถอดรหัส

โดยทั่วไปแล้ว ระบบ ML ใดๆ ที่แปลงจากระบบที่ประมวลผลแล้ว หนาแน่น หรือ การเป็นตัวแทนภายใน การเป็นตัวแทนที่เข้าใจอย่างแท้จริง หรือคลุมเครือมากขึ้น

ตัวถอดรหัสมักจะเป็นส่วนประกอบของโมเดลที่ใหญ่กว่า ซึ่งมัก จับคู่กับโปรแกรมเปลี่ยนไฟล์แล้ว

ในงานเกี่ยวกับลำดับต่อลำดับ เครื่องมือถอดรหัส เริ่มต้นด้วยสถานะภายในที่โปรแกรมเปลี่ยนไฟล์สร้างขึ้นเพื่อคาดการณ์สถานะถัดไป ตามลำดับ

โปรดดู Transformer สำหรับคำจำกัดความของตัวถอดรหัสภายใน สถาปัตยกรรม Transformer

การตัดเสียงรบกวน

แนวทางทั่วไปสำหรับการเรียนรู้ภายใต้การควบคุมดูแลด้วยตนเอง ที่:

- มีการเพิ่มเสียงรบกวนในชุดข้อมูลอย่างไม่เป็นจริง

- โมเดล จะพยายามนำสัญญาณรบกวนออก

การตัดเสียงรบกวนช่วยให้เรียนรู้จากตัวอย่างที่ไม่มีป้ายกำกับได้ ชุดข้อมูลเดิมทำหน้าที่เป็นเป้าหมายหรือ ป้ายกำกับ และ ข้อมูลที่รบกวนเป็นอินพุต

โมเดลภาษาที่มีการมาสก์บางรุ่นใช้การลดเสียงรบกวน ดังนี้

- มีการเพิ่มเสียงรบกวนในประโยคที่ไม่มีป้ายกำกับโดยปลอมตัวขึ้น โทเค็น

- โมเดลจะพยายามคาดการณ์โทเค็นเดิม

การแสดงข้อความแจ้งโดยตรง

คำพ้องของข้อความแจ้ง Zero Shot

E

แก้ไขระยะทาง

การวัดว่าสตริงข้อความ 2 สตริงมีความคล้ายคลึงกันอย่างไร ในแมชชีนเลิร์นนิง การแก้ไขระยะทางมีประโยชน์เนื่องจาก ประมวลผล และวิธีที่มีประสิทธิภาพในการเปรียบเทียบสองสตริงที่ทราบว่า คล้ายกันหรือค้นหาสตริงที่คล้ายกับสตริงที่ระบุ

มีคำจำกัดความมากมายสำหรับระยะการแก้ไข โดยแต่ละคำใช้สตริงที่แตกต่างกัน การดำเนินงาน ตัวอย่างเช่น พารามิเตอร์ ระยะทาง Levenshtein จะพิจารณาการลบ แทรก และแทนที่น้อยที่สุด

เช่น ระยะห่างระหว่าง Levenshtein ระหว่างคำว่า "หัวใจ" และ "ลูกดอก" เท่ากับ 3 เนื่องจากการแก้ไข 3 ครั้งต่อไปนี้เป็นการเปลี่ยนแปลงที่น้อยที่สุดที่จะเปลี่ยนเพียง 1 คำ เป็นอีกแบบคือ

- หัวใจ → deart (แทนที่ "h" ด้วย "d")

- deart → dart (ลบ "e")

- ลูกดอก → ลูกดอก (แทรกคำว่า "s")

เลเยอร์ที่ฝัง

เลเยอร์ที่ซ่อนอยู่พิเศษซึ่งฝึกบน ฟีเจอร์หมวดหมู่ที่มีมิติข้อมูลสูงเพื่อ ค่อยๆ เรียนรู้เกี่ยวกับเวกเตอร์ที่ฝังมิติข้อมูลที่ต่ำลง CANNOT TRANSLATE เลเยอร์การฝังช่วยให้โครงข่ายประสาทสามารถฝึกได้ไกลขึ้น มีประสิทธิภาพมากกว่าการฝึกอบรมเพียงฟีเจอร์เชิงหมวดหมู่ที่มีมิติเท่านั้น

ตัวอย่างเช่น ปัจจุบัน Earth สนับสนุนชนิดต้นไม้ประมาณ 73,000 ชนิด สมมติว่า

ชนิดต้นไม้เป็นคุณลักษณะในโมเดลของคุณ ดังนั้นโมเดลของคุณ

เลเยอร์อินพุตจะมีเวกเตอร์หนึ่งฮอต 73,000

ยาวหลายองค์ประกอบ

ตัวอย่างเช่น baobab อาจแสดงในลักษณะนี้

อาร์เรย์ 73,000 องค์ประกอบนั้นใช้เวลานานมาก หากคุณไม่ได้เพิ่มเลเยอร์ที่ฝัง กับโมเดลนี้ การฝึกจะใช้เวลานานมากเนื่องจาก คูณ 72,999 เลือกเลเยอร์การฝังเพื่อ จากมิติข้อมูล 12 รายการ เลเยอร์ที่ฝังจะค่อยๆ เรียนรู้ เวกเตอร์ที่ฝังใหม่ สำหรับชนิดของต้นไม้แต่ละชนิด

ในบางสถานการณ์ การแฮชเป็นทางเลือกที่สมเหตุสมผล ลงในเลเยอร์ที่ฝัง

พื้นที่ที่ฝัง

พื้นที่เวกเตอร์ d ของมิติข้อมูลที่แสดงจากมิติที่สูงกว่า ที่ตรงกับพื้นที่เวกเตอร์ โดยหลักการแล้ว พื้นที่ที่ฝังจะมี ที่ให้ผลลัพธ์ทางคณิตศาสตร์ที่มีความหมาย ตัวอย่างเช่น ในพื้นที่การฝังที่เหมาะสม การบวกและการลบการฝัง จะช่วยแก้ไขงานด้านการเทียบคำ

ผลิตภัณฑ์จุด ของการฝัง 2 จุดเป็นการวัดความคล้ายคลึงกัน

เวกเตอร์การฝัง

พูดกว้างๆ ก็คืออาร์เรย์ของจำนวนลอยตัวที่มาจากอะไรก็ได้ เลเยอร์ที่ซ่อนอยู่ที่อธิบายอินพุตของเลเยอร์ที่ซ่อนอยู่ บ่อยครั้งที่เวกเตอร์ที่ฝังคืออาร์เรย์ของจำนวนจุดลอยตัวที่ได้รับการฝึกใน เลเยอร์ที่ฝัง ตัวอย่างเช่น สมมติว่าเลเยอร์ที่ฝังเรียนรู้ การฝังเวกเตอร์สำหรับชนิดของต้นไม้แต่ละชนิดจากทั้งหมด 73,000 ชนิดบนโลก บางที อาร์เรย์ต่อไปนี้คือเวกเตอร์การฝังสำหรับต้นบาวบับ

เวกเตอร์ที่ฝังไม่ใช่กลุ่มของตัวเลขสุ่ม เลเยอร์ที่ฝัง กำหนดค่าเหล่านี้ผ่านการฝึก ซึ่งคล้ายกับวิธีการ โครงข่ายประสาทจะเรียนรู้การถ่วงน้ำหนักอื่นๆ ในระหว่างการฝึก องค์ประกอบแต่ละรายการของ อาร์เรย์ คือการให้คะแนนคุณลักษณะบางอย่างของชนิดพันธุ์ไม้ ซึ่ง แสดงว่าต้นไม้ชนิดใด ลักษณะเฉพาะ ยากมาก ให้มนุษย์ได้ทราบ

ส่วนที่มีความโดดเด่นทางคณิตศาสตร์ของเวกเตอร์ที่ฝังอยู่นั้น รายการมีชุดของจำนวนทศนิยมที่คล้ายกัน ตัวอย่างเช่น คล้ายกัน ชนิดของต้นไม้มีชุดของจำนวนจุดลอยตัวที่คล้ายกันมากกว่า ชนิดของต้นไม้ที่ไม่คล้ายกัน เรดวูดและซีคัวยาเป็นชนิดของต้นไม้ที่เกี่ยวข้อง เพื่อให้ได้ชุดตัวเลขทศนิยมที่คล้ายกันมากกว่า ต้นเรดวูดและต้นมะพร้าว ตัวเลขในเวกเตอร์ที่ฝังจะ เปลี่ยนทุกครั้งที่คุณฝึกโมเดลอีกครั้ง แม้ว่าคุณจะฝึกโมเดลอีกครั้งก็ตาม ด้วยอินพุตที่เหมือนกัน

โปรแกรมเปลี่ยนไฟล์

โดยทั่วไป ระบบ ML ใดๆ ที่แปลงจากข้อมูลดิบ บางส่วน หรือภายนอก เป็นตัวแทนที่ผ่านการประมวลผล ความหนาแน่น หรือชัดเจน มากยิ่งขึ้น

โปรแกรมเปลี่ยนไฟล์มักจะเป็นส่วนประกอบหนึ่งของโมเดลที่ใหญ่กว่า ซึ่งมัก จับคู่กับตัวถอดรหัสแล้ว Transformer บางรุ่น จับคู่โปรแกรมเปลี่ยนไฟล์กับตัวถอดรหัส แม้ว่า Transformer อื่นๆ จะใช้เฉพาะโปรแกรมเปลี่ยนไฟล์ หรือเฉพาะตัวถอดรหัสเท่านั้น

บางระบบใช้เอาต์พุตของโปรแกรมเปลี่ยนไฟล์เป็นอินพุตสำหรับการจัดประเภท หรือ ของ Google Cloud

ในงานเกี่ยวกับลำดับต่อลำดับ โปรแกรมเปลี่ยนไฟล์ รับลำดับอินพุตและส่งคืนสถานะภายใน (เวกเตอร์) จากนั้น ตัวถอดรหัสจะใช้สถานะภายในดังกล่าวเพื่อคาดการณ์ลำดับถัดไป

โปรดดู Transformer สำหรับคำจำกัดความของโปรแกรมเปลี่ยนไฟล์ใน สถาปัตยกรรม Transformer

F

ข้อความแจ้งใน 2-3 ช็อต

ข้อความแจ้งที่มีตัวอย่างมากกว่า 1 รายการ ("2-3") รายการ เพื่อสาธิตให้เห็นว่าโมเดลภาษาขนาดใหญ่ ควรตอบสนอง ตัวอย่างเช่น พรอมต์ยาวต่อไปนี้มี ตัวอย่างที่แสดงโมเดลภาษาขนาดใหญ่เกี่ยวกับวิธีตอบคำถาม

| ส่วนต่างๆ ของพรอมต์ | หมายเหตุ |

|---|---|

| สกุลเงินอย่างเป็นทางการของประเทศที่ระบุคืออะไร | คำถามที่ต้องการให้ LLM ตอบ |

| ฝรั่งเศส: EUR | ตัวอย่าง 1 รายการ |

| สหราชอาณาจักร: GBP | อีกตัวอย่างหนึ่ง |

| อินเดีย: | การค้นหาจริง |

โดยทั่วไปแล้ว การใส่ข้อความแจ้งเพียงน้อยครั้งจะให้ผลลัพธ์ที่น่าพอใจมากกว่า การแสดงข้อความแจ้งแบบ Zero shot และ การส่งข้อความแจ้งแบบครั้งเดียว อย่างไรก็ตาม การแสดงข้อความแจ้งเพียง 2-3 ช็อต ต้องใช้ข้อความแจ้งที่ยาวกว่านี้

การแจ้งเพียง 2-3 ช็อตเป็นการเรียนรู้แบบคร่าวๆ นำไปใช้กับการเรียนรู้จากพรอมต์

ฟิดเดิล

ไลบรารีการกำหนดค่าที่ใช้ Python เป็นหลักซึ่งตั้งค่า ค่าของฟังก์ชันและคลาสที่ไม่มีโค้ดหรือโครงสร้างพื้นฐานที่รุกล้ำเข้ามา ในกรณีของ Pax และโค้ดเบส ML อื่นๆ ฟังก์ชันเหล่านี้และ คลาสจะเป็นตัวแทนของโมเดลและการฝึก ไฮเปอร์พารามิเตอร์

ฟิดเดิล ถือว่าโดยทั่วไปแล้วโค้ดเบสแมชชีนเลิร์นนิงแบ่งออกเป็นสิ่งต่อไปนี้

- โค้ดไลบรารี ซึ่งระบุเลเยอร์และเครื่องมือเพิ่มประสิทธิภาพ

- "Glue" ชุดข้อมูล ซึ่งเรียกห้องสมุดและสายไฟเข้าด้วยกัน

Fiddle บันทึกโครงสร้างการเรียกใช้ของ Glue Code ในตัวแปรที่ยังไม่ผ่านการประเมินและ เปลี่ยนแปลงได้

การปรับแต่ง

บัตรผ่านการฝึกอบรมเฉพาะงานชิ้นที่ 2 ที่ดำเนินการใน โมเดลที่ฝึกล่วงหน้าเพื่อปรับแต่งพารามิเตอร์สำหรับ Use Case ที่เฉพาะเจาะจง ตัวอย่างเช่น ลำดับการฝึกที่สมบูรณ์สำหรับ โมเดลภาษาขนาดใหญ่มีดังนี้

- การฝึกล่วงหน้า: ฝึกโมเดลภาษาขนาดใหญ่ด้วยชุดข้อมูลทั่วไปขนาดใหญ่ เช่น หน้า Wikipedia ภาษาอังกฤษทั้งหมด

- การปรับแต่ง: ฝึกโมเดลก่อนการฝึกเพื่อทำงานที่ต้องการ เช่น การตอบคำถามทางการแพทย์ การปรับแต่งนั้นมักเกี่ยวข้องกับ ตัวอย่างนับร้อยหรือพันรายการที่มุ่งเน้นเฉพาะงานนั้นๆ

อีกตัวอย่างหนึ่งคือลำดับการฝึกที่สมบูรณ์สำหรับโมเดลรูปภาพขนาดใหญ่ ดังต่อไปนี้:

- การฝึกล่วงหน้า: ฝึกโมเดลรูปภาพขนาดใหญ่บนรูปภาพทั่วไปขนาดใหญ่ เช่น ภาพทั้งหมดใน Wikimedia Commons

- การปรับแต่ง: ฝึกโมเดลก่อนการฝึกเพื่อทำงานที่ต้องการ เช่น การสร้างรูปวาฬเพชฌฆาต

การปรับแต่งจะนำกลยุทธ์ต่อไปนี้ผสมกันในรูปแบบใดก็ได้

- การแก้ไขโมเดลที่มีอยู่ก่อนการฝึกที่มีอยู่ทั้งหมด พารามิเตอร์ ซึ่งในบางครั้งเรียกว่าการปรับแต่งอย่างละเอียด

- การแก้ไขพารามิเตอร์ที่มีอยู่ของโมเดลก่อนการฝึกบางส่วนเท่านั้น (โดยปกติคือเลเยอร์ที่อยู่ใกล้กับเลเยอร์เอาต์พุตมากที่สุด) โดยไม่เปลี่ยนแปลงพารามิเตอร์อื่นๆ ที่มีอยู่ (โดยทั่วไปคือเลเยอร์ ใกล้เลเยอร์อินพุตมากที่สุด) โปรดดู การปรับแต่งประสิทธิภาพพารามิเตอร์

- การเพิ่มเลเยอร์อีก โดยทั่วไปจะอยู่ด้านบนของเลเยอร์ที่มีอยู่ที่อยู่ใกล้กับเลเยอร์ เลเยอร์เอาต์พุต

การปรับแต่งเป็นการเรียนรู้การโอนรูปแบบหนึ่ง ด้วยเหตุนี้ การปรับแต่งอย่างละเอียดอาจใช้ฟังก์ชันการสูญเสียข้อมูลหรือโมเดลอื่น ประเภทที่นอกเหนือจากที่ใช้ในการฝึกโมเดลก่อนการฝึก ตัวอย่างเช่น คุณสามารถ ปรับแต่งโมเดลรูปภาพขนาดใหญ่ก่อนการฝึก เพื่อสร้างโมเดลการถดถอยที่ แสดงผลจำนวนนกในภาพอินพุต

เปรียบเทียบการปรับแต่งอย่างละเอียดกับคำต่อไปนี้

เหลืองแฟลกซ์

โอเพนซอร์สประสิทธิภาพสูง ไลบรารีสำหรับ การเรียนรู้เชิงลึกที่สร้างต่อยอดจาก JAX แฟลกซ์มีฟังก์ชันการทำงาน สำหรับการฝึก โครงข่ายประสาท รวมถึง เป็นวิธีการประเมินประสิทธิภาพ

Flaxformer

Transformer แบบโอเพนซอร์ส คลัง สร้างขึ้นบน Flax ที่ออกแบบมาเพื่อการประมวลผลภาษาธรรมชาติเป็นหลัก และการวิจัยสื่อหลากรูปแบบ

G

Generative AI

ช่องที่กำลังเปลี่ยนรูปแบบใหม่ซึ่งไม่มีคำจำกัดความอย่างเป็นทางการ อย่างไรก็ตาม ผู้เชี่ยวชาญส่วนใหญ่เห็นด้วยว่าโมเดล Generative AI สามารถ สร้าง ("สร้าง") เนื้อหาที่มีลักษณะต่อไปนี้ทั้งหมด

- ซับซ้อน

- สอดคล้องกัน

- เดิม

เช่น โมเดล Generative AI สามารถสร้างความซับซ้อน เรียงความหรือรูปภาพ

เทคโนโลยีบางรุ่นก่อนหน้านี้ รวมถึง LSTMs และ RNN ยังสามารถสร้างต้นฉบับและ ที่สอดคล้องกัน ผู้เชี่ยวชาญบางคนมองว่าเทคโนโลยีรุ่นก่อนหน้าเหล่านี้คือ ในขณะที่ Generative AI บางคนรู้สึกว่า Generative AI ที่แท้จริงนั้นต้องการความซับซ้อนกว่า มากกว่าที่เทคโนโลยีรุ่นก่อนๆ จะสร้างขึ้นได้

เปรียบเทียบกับ ML ที่คาดการณ์

GPT (Transformer ที่ฝึกล่วงหน้าด้วย Generative)

ตระกูลเกม Transformer โมเดลภาษาขนาดใหญ่ที่พัฒนาโดย OpenAI

ตัวแปร GPT ใช้ได้กับวิธีการหลายวิธี ได้แก่

- การสร้างรูปภาพ (เช่น ImageGPT)

- การสร้างข้อความเป็นรูปภาพ (เช่น DALL-E)

H

ความไม่สมเหตุสมผล

การสร้างผลลัพธ์ที่ดูสมเหตุสมผลแต่ไม่ถูกต้องตามข้อเท็จจริงโดย โมเดล Generative AI ที่อ้างว่าจะสร้าง ความจริงเกี่ยวกับโลกความเป็นจริง ตัวอย่างเช่น โมเดล Generative AI ที่อ้างว่าบารัก โอบามาเสียชีวิตในปี 1865 ความไม่สมเหตุสมผล

I

การเรียนรู้ในบริบท

คำพ้องความหมายของข้อความแจ้งไม่กี่ช็อต

L

LaMDA (โมเดลภาษาสำหรับแอปพลิเคชันด้านการสนทนา)

เกมจากTransformer โมเดลภาษาขนาดใหญ่ที่พัฒนาโดย Google ผ่านการฝึกอบรมเกี่ยวกับ ชุดข้อมูลการสนทนาขนาดใหญ่ที่สามารถสร้างการตอบกลับแบบสนทนาที่สมจริง

LaMDA: การสนทนาเกี่ยวกับความสำเร็จของเรา เทคโนโลยีจะให้ภาพรวม

โมเดลภาษา

โมเดลที่ประมาณความน่าจะเป็นของโทเค็น หรือลำดับโทเค็นที่เกิดขึ้นตามลำดับของโทเค็นที่ยาวกว่า

โมเดลภาษาขนาดใหญ่

คำศัพท์ที่ไม่เป็นทางการซึ่งไม่มีคำจำกัดความที่เข้มงวดซึ่งมักหมายถึง โมเดลภาษาที่มี โมเดลภาษาจำนวนมาก พารามิเตอร์ โมเดลภาษาขนาดใหญ่บางโมเดลมีพารามิเตอร์มากกว่า 1 แสนล้านพารามิเตอร์

พื้นที่แฝง

คำพ้องความหมายของ การฝังพื้นที่

LLM

ตัวย่อของ โมเดลภาษาขนาดใหญ่

LoRA

ตัวย่อของความสามารถในการปรับตัวระดับต่ำ

ความสามารถในการปรับตัวระดับต่ำ (LoRA)

อัลกอริทึมสำหรับการแสดง การปรับแต่งประสิทธิภาพพารามิเตอร์ที่ ปรับแต่งเฉพาะชุดย่อยของ พารามิเตอร์ของโมเดลภาษาขนาดใหญ่ LoRA มีประโยชน์ดังนี้

- การปรับแต่งเร็วกว่าเทคนิคที่ต้องปรับแต่งโมเดลทั้งหมดอย่างละเอียด พารามิเตอร์

- ลดต้นทุนการคำนวณของการอนุมานใน โมเดลที่ปรับแต่งแล้ว

โมเดลที่ปรับแต่งด้วย LoRA จะรักษาหรือปรับปรุงคุณภาพของการคาดการณ์

LoRA จะเปิดใช้เวอร์ชันพิเศษที่หลากหลายของโมเดล

M

โมเดลภาษามาสก์

โมเดลภาษาที่คาดการณ์ความน่าจะเป็นของ โทเค็นของผู้สมัครเพื่อเติมในช่องว่างตามลำดับ ตัวอย่างเช่น โมเดลภาษามาสก์สามารถคำนวณความน่าจะเป็นของคำที่รอการพิจารณา เพื่อแทนที่เส้นใต้ในประโยคต่อไปนี้

____ ในหมวกก็กลับมา

โดยปกติแล้ว วรรณกรรมจะใช้สตริง "MASK" แทนเส้นใต้ เช่น

"MASK" ที่ใส่หมวกกลับมา

โมเดลภาษาที่มีการมาสก์สมัยใหม่ส่วนใหญ่จะเป็นแบบ2 ทิศทาง

การเรียนรู้เมตา

ชุดย่อยของแมชชีนเลิร์นนิงที่ค้นพบหรือปรับปรุงอัลกอริทึมการเรียนรู้ ระบบการเรียนรู้เมตายังสามารถมุ่งฝึกโมเดลให้เรียนรู้ งานจากข้อมูลเล็กน้อยหรือจากประสบการณ์ที่ได้รับในงานก่อนหน้า โดยทั่วไป อัลกอริทึมของการเรียนรู้เมตาจะพยายามทำให้สำเร็จดังต่อไปนี้

- ปรับปรุงหรือเรียนรู้ฟีเจอร์ที่ออกแบบเองด้วยมือ (เช่น โปรแกรมเริ่มต้นหรือ เครื่องมือเพิ่มประสิทธิภาพ)

- ประหยัดข้อมูลและการประมวลผลได้มากขึ้น

- ปรับปรุงการสรุป

การเรียนรู้เมตาเกี่ยวข้องกับการเรียนรู้เพียงสั้นๆ

รูปแบบ

หมวดหมู่ข้อมูลระดับสูง เช่น ตัวเลข ข้อความ รูปภาพ วิดีโอ และ เสียงมีอยู่ด้วยกัน 5 วิธี

การทำงานพร้อมกันของโมเดล

วิธีปรับขนาดการฝึกหรือการอนุมานที่อิงจากส่วนต่างๆ ของการฝึก model ในอุปกรณ์ต่างๆ กัน การทำงานพร้อมกันของโมเดล จะเปิดใช้โมเดลที่ใหญ่เกินไปเพื่อให้พอดีกับอุปกรณ์ 1 เครื่อง

หากต้องการใช้โมเดลคู่ขนาน ระบบมักจะดำเนินการดังต่อไปนี้

- ชาร์ด (แบ่ง) โมเดลออกเป็นส่วนเล็กๆ

- กระจายการฝึกของชิ้นส่วนขนาดเล็กเหล่านั้นในโปรเซสเซอร์หลายตัว ตัวประมวลผลแต่ละตัวจะฝึกส่วนของโมเดลของตัวเอง

- รวมผลลัพธ์เพื่อสร้างรูปแบบเดียว

โมเดลคู่ขนานทำให้การฝึกช้าลง

โปรดดูเพิ่มเติมที่ข้อมูลที่ทำงานพร้อมกัน

ความสนใจตนเองแบบหลายศีรษะ

ส่วนขยายของการเอาใจใส่ตนเองที่ใช้ กลไกการทำงานด้วยตนเองหลายครั้งสำหรับแต่ละตำแหน่งในลำดับอินพุต

Transformers เปิดตัวความสนใจในตัวระบบแบบหลายหัว

โมเดลสื่อหลากรูปแบบ

โมเดลที่มีอินพุตและ/หรือเอาต์พุตมีมากกว่า 1 รายการ วิธีการ ตัวอย่างเช่น ลองพิจารณาโมเดลที่นำทั้ง คำบรรยายรูปภาพและข้อความ (2 วิธี) เป็นฟีเจอร์ และ จะแสดงคะแนนที่ระบุว่าคำอธิบายข้อความมีความเหมาะสมสำหรับภาพมากน้อยเพียงใด อินพุตของโมเดลนี้เป็นแบบมัลติโมดัลและเอาต์พุตจะเป็นแบบเอกพจน์

N

ความเข้าใจภาษาธรรมชาติ

การพิจารณาความตั้งใจของผู้ใช้ตามสิ่งที่ผู้ใช้พิมพ์หรือพูด ตัวอย่างเช่น เครื่องมือค้นหาใช้ความเข้าใจภาษาที่เป็นธรรมชาติเพื่อ ระบุสิ่งที่ผู้ใช้กำลังค้นหาตามสิ่งที่ผู้ใช้พิมพ์หรือพูด

เอ็นกรัม

การเรียงลำดับของ N คำ เช่น บ้าจริง คือ 2 กรัม เพราะ คำสั่งซื้อนั้นเกี่ยวข้อง แต่จริงๆ แล้วจริงๆ เป็น 2 กรัมที่ต่างจากจริงๆ แล้วบ้า

| N | ชื่อของ N-gram ประเภทนี้ | ตัวอย่าง |

|---|---|---|

| 2 | Bigram หรือ 2 กรัม | ไป ไป กินข้าวกลางวัน มื้อเย็น |

| 3 | ไตรแกรม หรือ 3 กรัม | กินมากเกินไป หนูตาบอด 3 ตัว ค่าโทร |

| 4 | 4 กรัม | เดินเล่นในสวนสาธารณะ สัมผัสสายลม เด็กหนุ่มกินถั่วเลนทิล |

การทำความเข้าใจภาษาธรรมชาติหลายๆ อย่าง โมเดลอาศัยหน่วย N กรัมในการคาดการณ์คำถัดไปที่ผู้ใช้จะพิมพ์ หรือพูด ตัวอย่างเช่น สมมติว่าผู้ใช้พิมพ์ 3Bดูด โมเดล NLU ที่ใช้ Trigrams น่าจะคาดการณ์ได้ว่า ผู้ใช้จะพิมพ์คำว่า เมาส์

เปรียบเทียบขนาด N กรัมกับกลุ่มคำ ที่ กลุ่มคำที่ไม่ได้เรียงลำดับ

NLU

ตัวย่อของภาษาธรรมชาติ ความเข้าใจ

O

การแสดงข้อความแจ้งแบบครั้งเดียว

ข้อความแจ้งที่มีหนึ่งตัวอย่างที่แสดงให้เห็นว่า โมเดลภาษาขนาดใหญ่ควรตอบสนอง ตัวอย่างเช่น พรอมต์ต่อไปนี้มีตัวอย่าง 1 รายการที่แสดงโมเดลภาษาขนาดใหญ่ ก็ควรตอบคำถามได้

| ส่วนต่างๆ ของพรอมต์ | หมายเหตุ |

|---|---|

| สกุลเงินอย่างเป็นทางการของประเทศที่ระบุคืออะไร | คำถามที่ต้องการให้ LLM ตอบ |

| ฝรั่งเศส: EUR | ตัวอย่าง 1 รายการ |

| อินเดีย: | การค้นหาจริง |

เปรียบเทียบระหว่างพรอมต์แบบช็อตเดียวกับคำต่อไปนี้

P

การปรับแต่งประสิทธิภาพพารามิเตอร์

ชุดเทคนิคในการปรับแต่ง โมเดลภาษาก่อนการฝึก (PLM) มีประสิทธิภาพมากกว่าการปรับแต่งแบบเต็มรูปแบบ ประสิทธิภาพของพารามิเตอร์ การปรับแต่งมักจะปรับแต่งได้น้อยกว่า พารามิเตอร์ มาก การปรับแต่ง แต่โดยทั่วไปแล้วก็จะสร้าง โมเดลภาษาขนาดใหญ่ที่มีประสิทธิภาพ รวมถึงโมเดลภาษาขนาดใหญ่ที่สร้างจาก ของ Google

เปรียบเทียบระหว่างการปรับแต่งที่มีประสิทธิภาพพารามิเตอร์กับ

การปรับแต่งอย่างมีประสิทธิภาพพารามิเตอร์เรียกอีกอย่างว่าการปรับแต่งโดยละเอียดโดยใช้พารามิเตอร์

การไปป์ท่อ

รูปแบบของโมเดลคู่ขนานที่โมเดลของ การประมวลผลจะแบ่งออกเป็นระยะต่อเนื่องกันและดำเนินการตามแต่ละระยะ บนอุปกรณ์อื่น ขณะที่ขั้นตอนกำลังประมวลผล 1 กลุ่ม พารามิเตอร์ สามารถทำงานกับแบตช์ถัดไปได้

ดูการฝึกอบรมแบบทีละขั้นเพิ่มเติม

PLM

ตัวย่อของโมเดลภาษาก่อนการฝึก

การเข้ารหัสตำแหน่ง

เทคนิคในการเพิ่มข้อมูลเกี่ยวกับตำแหน่งของโทเค็นตามลำดับเพื่อ กับการฝังโทเค็น โมเดลหม้อแปลงใช้ตำแหน่ง เพื่อทำความเข้าใจความสัมพันธ์ระหว่างส่วนต่างๆ ของ ตามลำดับ

การใช้งานการเข้ารหัสตำแหน่งโดยทั่วไปจะใช้ฟังก์ชันไซนัสซอยด์ (โดยเฉพาะอย่างยิ่ง ความถี่และแอมพลิจูดของฟังก์ชันไซนัสซอยด์ ซึ่งกำหนดโดยตำแหน่งของโทเค็นในลำดับ) เทคนิคนี้ ทำให้โมเดล Transformer ได้เรียนรู้ที่จะมีส่วนร่วมในส่วนต่างๆ ของ ตามลำดับตามตำแหน่ง

โมเดลก่อนการฝึก

โมเดลหรือคอมโพเนนต์ของโมเดล (เช่น เวกเตอร์การฝัง) ที่ได้รับการฝึกแล้ว บางครั้งคุณจะป้อนเวกเตอร์ที่มีการฝังก่อนการฝึกลงใน โครงข่ายระบบประสาทเทียม แต่บางครั้ง โมเดลของคุณจะฝึก ฝังเวกเตอร์ด้วยตนเอง แทนที่จะใช้การฝังที่ได้รับการฝึกล่วงหน้า

คำว่าโมเดลภาษาก่อนการฝึกหมายถึง โมเดลภาษาขนาดใหญ่ที่ได้ผ่านการทดสอบ การฝึกอบรมล่วงหน้า

การฝึกล่วงหน้า

การฝึกเริ่มต้นของโมเดลในชุดข้อมูลขนาดใหญ่ โมเดลก่อนการฝึกบางรุ่น เป็นยักษ์จอมซุ่มและมักจะต้องได้รับการปรับปรุงผ่านการฝึกอบรมเพิ่มเติม ตัวอย่างเช่น ผู้เชี่ยวชาญด้าน ML อาจฝึกอบรม โมเดลภาษาขนาดใหญ่บนชุดข้อมูลข้อความขนาดใหญ่ เช่นหน้าภาษาอังกฤษทั้งหมดใน Wikipedia หลังจากการฝึกอบรมล่วงหน้า โมเดลผลลัพธ์อาจได้รับการปรับแต่งเพิ่มเติมผ่านเกณฑ์ต่อไปนี้ เทคนิค

ข้อความแจ้ง

ข้อความที่ป้อนเป็นอินพุตในโมเดลภาษาขนาดใหญ่ เพื่อกำหนดเงื่อนไขของโมเดลให้ทำงานในลักษณะต่างๆ พรอมต์อาจสั้นเป็น วลีหรือยาวโดยไม่มีกฎเกณฑ์ (เช่น ข้อความทั้งหมดในนิยาย) พรอมต์ แบ่งออกเป็นหลายหมวดหมู่ ซึ่งรวมถึงหมวดหมู่ที่แสดงในตารางต่อไปนี้

| หมวดหมู่ข้อความแจ้ง | ตัวอย่าง | หมายเหตุ |

|---|---|---|

| คำถาม | นกพิราบบินได้เร็วแค่ไหน | |

| โรงเรียนฝึกอบรม | เขียนกลอนตลกๆ เกี่ยวกับการหากำไร | พรอมต์ที่ขอให้โมเดลภาษาขนาดใหญ่ทำบางอย่าง |

| ตัวอย่าง | แปลโค้ดมาร์กดาวน์เป็น HTML ดังตัวอย่างต่อไปนี้

มาร์กดาวน์: * รายการ HTML: <ul> <li>รายการ</li> </ul> |

ประโยคแรกในพรอมต์ตัวอย่างนี้คือคำสั่ง ส่วนที่เหลือของข้อความแจ้งเป็นตัวอย่าง |

| บทบาท | อธิบายเหตุผลที่ต้องใช้การไล่ระดับสีในการฝึกแมชชีนเลิร์นนิงเพื่อ ปริญญาเอกสาขาฟิสิกส์ | ส่วนแรกของประโยคเป็นคำสั่ง วลี "เรียนปริญญาเอกในสาขาฟิสิกส์" คือส่วนของบทบาท |

| ป้อนข้อมูลบางส่วนสำหรับโมเดลให้เสร็จสมบูรณ์ | นายกรัฐมนตรีของสหราชอาณาจักรอาศัยอยู่ที่ | พรอมต์อินพุตบางส่วนอาจสิ้นสุดลงทันที (ดังตัวอย่างนี้) หรือลงท้ายด้วยขีดล่างก็ได้ |

โมเดล Generative AI สามารถตอบสนองต่อพรอมต์ด้วยข้อความ โค้ด รูปภาพ การฝัง วิดีโอ หรือแทบจะทุกอย่าง

การเรียนรู้จากพรอมต์

ความสามารถของโมเดลบางรูปแบบที่ช่วยให้ปรับเปลี่ยนได้ พฤติกรรมของผู้ใช้ตามการป้อนข้อความที่กำหนดเอง (พรอมต์) ในกระบวนทัศน์การเรียนรู้จากพรอมต์ทั่วไป โมเดลภาษาขนาดใหญ่ตอบสนองต่อพรอมต์โดย การสร้างข้อความ เช่น สมมติว่าผู้ใช้ป้อนพรอมต์ต่อไปนี้

สรุปกฎการเคลื่อนที่ข้อที่ 3 ของนิวตัน

โมเดลที่สามารถเรียนรู้จากพรอมต์ไม่ได้มีการฝึกให้ตอบคำถามโดยเฉพาะ ข้อความแจ้งก่อนหน้า แต่โมเดล "รู้" ข้อเท็จจริงมากมายเกี่ยวกับฟิสิกส์ เกี่ยวกับกฎภาษาทั่วไปได้มากมาย และพูดถึงสิ่งที่ประกอบขึ้นเป็นโดยทั่วไปแล้ว คำตอบที่มีประโยชน์ ความรู้ดังกล่าวเพียงพอที่จะให้ (หวังว่า) คำตอบ ความคิดเห็นเพิ่มเติมจากมนุษย์ ("คำตอบนั้นซับซ้อนเกินไป" หรือ "What's aรีแอ็กชัน?") ช่วยให้ระบบการเรียนรู้ที่ใช้พรอมต์บางระบบค่อยๆ เรียนรู้ได้ ปรับปรุงประโยชน์ของคำตอบได้

การออกแบบพรอมต์

คำพ้องของ prompt Engineering

พรอมต์วิศวกรรม

ศิลปะการสร้างข้อความแจ้งที่กระตุ้นให้เกิดคำตอบที่ต้องการ จากโมเดลภาษาขนาดใหญ่ มนุษย์แสดงพรอมต์ วิศวกรรมศาสตร์ การเขียนพรอมต์แบบมีโครงสร้างที่ดีเป็นส่วนสำคัญในการสร้างความมั่นใจ คำตอบที่เป็นประโยชน์จากโมเดลภาษาขนาดใหญ่ วิศวกรรมพรอมต์ขึ้นอยู่กับ หลายปัจจัย ได้แก่

- ชุดข้อมูลที่ใช้ในการฝึกล่วงหน้าและอาจ ปรับแต่งโมเดลภาษาขนาดใหญ่

- temperature และพารามิเตอร์การถอดรหัสอื่นๆ ที่ โมเดลใช้ในการสร้างคำตอบ

โปรดดู ข้อมูลเบื้องต้นเกี่ยวกับการออกแบบพรอมต์ เพื่อดูรายละเอียดเพิ่มเติมเกี่ยวกับการเขียนพรอมต์ที่เป็นประโยชน์

การออกแบบพรอมต์เป็นคำพ้องความหมายของพรอมต์วิศวกรรม

การปรับแต่งพรอมต์

กลไกการปรับแต่งประสิทธิภาพของพารามิเตอร์ ที่เรียนรู้ "คำนำหน้า" ที่ระบบเพิ่มไว้ข้างหน้า ข้อความแจ้งจริง

รูปแบบหนึ่งของการปรับแต่งพรอมต์ ซึ่งบางครั้งเรียกว่าการปรับแต่งคำนำหน้า คือการ ใส่คำนำหน้าที่ทุกเลเยอร์ ในทางตรงกันข้าม การปรับแต่งพรอมต์ส่วนใหญ่ เพิ่มคำนำหน้าลงในเลเยอร์อินพุต

R

การแสดงข้อความแจ้งบทบาท

ส่วนที่ไม่บังคับของข้อความแจ้งที่ระบุกลุ่มเป้าหมาย สำหรับคำตอบของโมเดล Generative AI ไม่มีบทบาท โมเดลภาษาขนาดใหญ่จะให้คำตอบที่อาจมีประโยชน์หรือไม่มีประโยชน์ สำหรับผู้ที่ถามคำถาม เมื่อมีพรอมต์บทบาท ภาษาขนาดใหญ่ สามารถตอบคำถามในลักษณะที่เหมาะสมและมีประโยชน์มากขึ้นสำหรับ ผู้ชมเป้าหมายที่เฉพาะเจาะจง ตัวอย่างเช่น ส่วนข้อความแจ้งเกี่ยวกับบทบาทของข้อมูลต่อไปนี้ พรอมต์จะเป็นตัวหนา

- สรุปบทความนี้สำหรับปริญญาเอกด้านเศรษฐศาสตร์

- อธิบายวิธีการทำงานของกระแสน้ำสำหรับเด็กอายุ 10 ปี

- อธิบายวิกฤตการณ์ทางการเงินปี 2008 พูดในแบบที่คุณกับเด็กเล็ก หรือโกลเด้นรีทรีฟเวอร์

S

การจดจ่อกับตนเอง (หรือเรียกว่า เลเยอร์ความสนใจตนเอง)

ชั้นโครงข่ายระบบประสาทเทียมที่เปลี่ยนลำดับของ การฝัง (เช่น การฝัง โทเค็น) ลงในการฝังอีกลำดับ การฝังแต่ละรายการในลำดับเอาต์พุต สร้างขึ้นโดยการผสานรวมข้อมูลจากองค์ประกอบของลำดับอินพุต ผ่านกลไก Attention

ส่วนตัวเองของการดึงดูดตนเองหมายถึงลำดับการเข้าร่วม แทนบริบทอื่นๆ บางอย่าง การใส่ใจตนเองเป็นหนึ่งใน องค์ประกอบที่ใช้สร้างสรรค์สำหรับ Transformers และใช้การค้นหาพจนานุกรม คำศัพท์อย่าง "query", "key" และ "value"

เลเยอร์ความสนใจตนเองจะเริ่มต้นด้วยลำดับการนำเสนออินพุต ซึ่งก็คือ สำหรับแต่ละคำ การนำเสนออินพุตสำหรับคำอาจเป็น การฝังวิดีโอ สำหรับแต่ละคำในลำดับอินพุต เครือข่าย จะแสดงความเกี่ยวข้องของคำกับทุกองค์ประกอบในลำดับทั้งหมดของ คำ คะแนนความเกี่ยวข้องจะเป็นตัวกำหนดว่า คำนั้นๆ จะมีความหมายมากน้อยเพียงใด ประกอบด้วยการแทนคำอื่นๆ

ตัวอย่างเช่น ลองพิจารณาประโยคต่อไปนี้

สัตว์ตัวนี้ไม่เดินข้ามถนนเพราะเหนื่อยเกินไป

ภาพประกอบต่อไปนี้ (จาก Transformer: สถาปัตยกรรมโครงข่ายระบบประสาทเทียมใหม่สำหรับภาษา ทำความเข้าใจ) แสดงรูปแบบความสนใจของเลเยอร์ความสนใจตนเองสำหรับคำสรรพนามนี้ โดย ความมืดของแต่ละบรรทัดแสดงว่าแต่ละคำมีส่วนทำให้เกิด การนำเสนอ:

เลเยอร์การใส่ใจตนเองจะไฮไลต์คำที่เกี่ยวข้องกับ "เนื้อหานั้น" ด้วยวิธีนี้ ชั้นความสนใจได้เรียนรู้วิธีไฮไลต์คำที่ หมายถึงการกำหนดน้ำหนักสูงสุดให้กับสัตว์

สำหรับลำดับของ n โทเค็น ความสนใจตนเองจะแปลงลำดับ ของการฝัง n ครั้งแยกกัน หนึ่งครั้งที่แต่ละตำแหน่งในลำดับ

โปรดอ่านความสนใจและ การดึงดูดความสนใจในตัว (Multi-head)

การวิเคราะห์ความเห็น

การใช้อัลกอริทึมทางสถิติหรือแมชชีนเลิร์นนิงในการกำหนด ทัศนคติโดยรวมไม่ว่าจะเป็นเชิงบวกหรือเชิงลบต่อบริการ ผลิตภัณฑ์ องค์กร หรือหัวข้อ ตัวอย่างเช่น การใช้ การทำความเข้าใจภาษาธรรมชาติ อัลกอริทึมสามารถทำการวิเคราะห์ความเห็นเกี่ยวกับความคิดเห็นที่เป็นข้อความ จากหลักสูตรของมหาวิทยาลัย เพื่อกำหนดระดับปริญญาที่นักศึกษา โดยทั่วไปชอบหรือไม่ชอบหลักสูตรนั้น

งานตามลำดับสู่ลำดับ

งานที่แปลงลำดับอินพุตของโทเค็นเป็นเอาต์พุต ลำดับโทเค็น เช่น ลำดับต่อลำดับที่นิยมใช้กัน 2 ประเภท ได้แก่

- นักแปล:

- ตัวอย่างลำดับการป้อนข้อมูล: "ฉันรักคุณ"

- ตัวอย่างลำดับเอาต์พุต: "Je t'aime"

- การตอบคำถาม:

- ตัวอย่างลำดับอินพุต: "ฉันต้องใช้รถของฉันในนิวยอร์กซิตี้ไหม"

- ตัวอย่างลำดับเอาต์พุต: "ไม่ โปรดเก็บรถไว้ที่บ้าน"

skip-gram

n-gram ที่อาจข้าม (หรือ "ข้าม") คำจากต้นฉบับ ซึ่งหมายความว่าแต่เดิม คำ N อาจไม่ได้อยู่ติดกัน เพิ่มเติม สัญลักษณ์ "k-skip-n-gram" เป็น n-gram ที่สามารถมีได้ถึง k คำ ถูกข้าม

เช่น "สุนัขจิ้งจอกที่ปราดเปรื่อง" มี 2 กรัมที่เป็นไปได้ดังนี้

- "เร็ว"

- "สีน้ำตาลคัทชู"

- "จิ้งจอกสีน้ำตาล"

ตัวอย่าง "1 กรัม" คือคู่ของคำที่มีคำอื่นไม่เกิน 1 คำ ดังนั้น "สุนัขจิ้งจอกที่ปราดเปรียวสีน้ำตาล" มีอาหารข้าม 1 กรัม 1 กรัมดังต่อไปนี้

- "สีน้ำตาล"

- "จิ้งจอกด่วน"

นอกจากนี้ น้ำหนัก 2 กรัมทั้งหมดยังมี 1 กิโลกรัม 1-2 กรัมเพราะน้อยกว่า อาจถูกข้ามคำมากกว่า 1 คำ

ปุ่มข้ามมีประโยชน์สำหรับการทำความเข้าใจบริบทรอบข้างของคำมากขึ้น ในตัวอย่างนี้ "สุนัขจิ้งจอก" เกี่ยวข้องโดยตรงกับ "โฆษณาด่วน" ในชุดของ 1 ข้าม 2 กรัม แต่ไม่ได้อยู่ในชุด 2 กรัม

ฝึกสอนวิธีข้ามกรัม รูปแบบการฝังคำ

การปรับแต่งพรอมต์แบบนุ่มนวล

เทคนิคในการปรับแต่งโมเดลภาษาขนาดใหญ่ สำหรับงานบางอย่าง โดยไม่ต้องใช้ทรัพยากรมากมาย การปรับแต่ง แทนที่จะต้องฝึกอบรม น้ำหนักในโมเดล การปรับแต่งซอฟต์พรอมต์ ปรับข้อความแจ้งโดยอัตโนมัติเพื่อให้บรรลุเป้าหมายเดียวกัน

เมื่อมีพรอมต์ข้อความ การปรับแต่งพรอมต์แบบนุ่มนวล มักจะเพิ่มการฝังโทเค็นเพิ่มเติมลงในข้อความแจ้งและใช้ Backpropagation จะเพิ่มประสิทธิภาพอินพุต

"ยาก" จะมีโทเค็นจริงแทนที่จะเป็นการฝังโทเค็น

ฟีเจอร์บางส่วน

ฟีเจอร์ที่มีค่าเป็น 0 หรือเป็นค่าว่างเป็นส่วนใหญ่ ตัวอย่างเช่น ฟีเจอร์ที่มีค่า 1 ค่าเดียวและ 0 ล้านค่าเป็น 0 ล้านค่า Sparse ในทางตรงกันข้าม ฟีเจอร์ความหนาแน่นมีค่าที่ ไม่ควรเป็น 0 หรือว่างเปล่าเป็นหลัก

ในแมชชีนเลิร์นนิง ฟีเจอร์จำนวนที่ไม่น้อยก็คือฟีเจอร์จำนวนน้อย ฟีเจอร์เชิงหมวดหมู่มักจะเป็นองค์ประกอบแบบคร่าวๆ ตัวอย่างเช่น จากจำนวนต้นไม้ที่เป็นไปได้ 300 ชนิดในป่า 1 ตัวอย่าง อาจระบุแค่ต้นเมเปิล หรือจากวิดีโอหลายล้านรายการ ของวิดีโอที่เป็นไปได้ในไลบรารีวิดีโอ ตัวอย่างหนึ่งอาจระบุ แค่ "Casablanca"

ในโมเดล คุณมักจะแสดงคุณลักษณะที่มีขนาดเล็กด้วย การเข้ารหัสแบบฮอตเดียว หากการเข้ารหัสแบบ One-hot มีขนาดใหญ่ คุณอาจวางเลเยอร์การฝังทับ เพื่อประสิทธิภาพที่ดียิ่งขึ้น

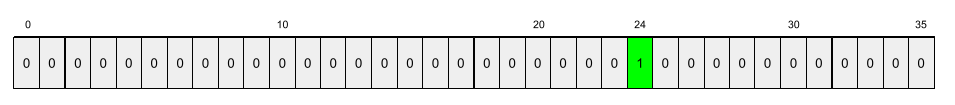

การนำเสนอแบบกระจัดกระจาย

จัดเก็บเฉพาะตำแหน่งขององค์ประกอบที่ไม่ใช่ 0 ในฟีเจอร์บางส่วน

ตัวอย่างเช่น สมมติว่าฟีเจอร์เชิงหมวดหมู่ชื่อ species ระบุรหัส 36

ชนิดของต้นไม้ในป่าแห่งหนึ่ง สมมติว่าแต่ละ

example ระบุสปีชีส์เพียงชนิดเดียว

คุณสามารถใช้เวกเตอร์ร้อนเดียวเพื่อแสดงสปีชีส์ของต้นไม้ในแต่ละตัวอย่างได้

เวกเตอร์หนึ่งฮ็อตจะมี 1 เดี่ยว (เพื่อแสดง

ชนิดของต้นไม้ในตัวอย่างดังกล่าว) และ 35 0 (เพื่อแสดง

ประเภทต้นไม้ 35 ชนิดที่ไม่ได้ในตัวอย่างนี้) ดังนั้น การนำเสนอที่น่าสนใจ

ของ maple อาจมีลักษณะดังต่อไปนี้

อีกทางเลือกหนึ่งคือการนำเสนอแบบคร่าวๆ จะระบุตำแหน่งของ

สายพันธุ์เฉพาะ หาก maple อยู่ที่ตำแหน่ง 24 การแสดงค่าเพียงเล็กน้อย

ของ maple จะเป็นดังนี้

24

สังเกตว่าการนำเสนอแบบกระทัดรัดจะเป็นแบบร้อนแรงเพียงรอบเดียวมาก การให้คำแนะนำ

การฝึกอบรมแบบทีละขั้น

กลยุทธ์ของการฝึกโมเดลตามลำดับขั้นที่ไม่ต่อเนื่องกัน เป้าหมายอาจเป็น เพื่อเร่งกระบวนการฝึก หรือเพื่อให้โมเดลมีคุณภาพดีขึ้น

ภาพประกอบของวิธีการกองซ้อนแบบโพรเกรสซีฟแสดงอยู่ด้านล่าง

- ขั้นที่ 1 มีเลเยอร์ที่ซ่อนอยู่ 3 เลเยอร์ ขั้นที่ 2 มีเลเยอร์ที่ซ่อนอยู่ 6 เลเยอร์ และ ขั้นที่ 3 มีเลเยอร์ที่ซ่อนอยู่ 12 เลเยอร์

- ขั้นที่ 2 เริ่มการฝึกโดยใช้การยกน้ำหนักที่เรียนรู้ในเลเยอร์ที่ซ่อนอยู่ 3 ชั้น ของขั้นที่ 1 ขั้นที่ 3 เริ่มการฝึกโดยใช้การยกน้ำหนักที่เรียนรู้ในข้อ 6 เลเยอร์ที่ซ่อนอยู่ของระยะที่ 2

ดูเพิ่มเติมได้ที่ไปป์ไลน์

โทเค็นคำย่อย

ในโมเดลภาษา โทเค็นที่เป็น สตริงย่อยของคำ ซึ่งอาจเป็นทั้งคำ

เช่น คำอย่าง "itemize" อาจถูกแบ่งออกเป็นชิ้นส่วน "item" (คำราก) และ "ize" (คำต่อท้าย) ซึ่งจะแสดงแต่ละค่าเป็นของตัวเอง โทเค็น การแยกคำที่ไม่เป็นที่นิยมออกเป็นส่วนๆ ที่เรียกว่า "คำย่อย" ช่วยให้ โมเดลภาษาเพื่อดำเนินการในส่วนส่วนประกอบของคำที่พบได้ทั่วไปมากขึ้น เช่น คำนำหน้าและคำต่อท้าย

ในทางกลับกัน คำทั่วไป เช่น "ไป" อาจจะยังไม่เพียงพอและอาจ จะแสดงด้วยโทเค็นเดียว

T

T5

โมเดลการโอนการเรียนรู้จากการแปลงข้อความเป็นข้อความ แนะนำโดย AI ของ Google ในปี 2020 T5 คือโมเดลโปรแกรมเปลี่ยนไฟล์-ตัวถอดรหัส ที่อิงจาก สถาปัตยกรรม Transformer ซึ่งได้รับการฝึกด้วยโมเดลขนาดใหญ่ ชุดข้อมูล มีประสิทธิภาพในงานประมวลผลภาษาธรรมชาติแบบต่างๆ เช่น การสร้างข้อความ การแปลภาษา และการตอบคำถามใน ในการพูดคุยอย่างเป็นกันเอง

T5 ได้ชื่อมาจากตัว T ทั้ง 5 ตัวใน "Text-to-Text Transfer Transformer"

แบบ T5X

เฟรมเวิร์กแมชชีนเลิร์นนิงแบบโอเพนซอร์สที่ออกแบบ เพื่อสร้างและฝึกการประมวลผลภาษาธรรมชาติขนาดใหญ่ (NLP) T5 ใช้งานได้บน Codebase T5X (ซึ่งก็คือ สร้างขึ้นใน JAX และ Flax)

อุณหภูมิ

พารามิเตอร์ไฮเปอร์พารามิเตอร์ที่ควบคุมระดับของการสุ่ม ของเอาต์พุตโมเดล อุณหภูมิที่สูงขึ้น จะเกิดผลลัพธ์แบบสุ่มมากขึ้น ขณะที่อุณหภูมิที่ต่ำลง จะทำให้เอาต์พุตแบบสุ่มน้อยลง

การเลือกอุณหภูมิที่ดีที่สุดจะขึ้นอยู่กับการใช้งานเฉพาะและ พร็อพเพอร์ตี้ที่ต้องการของเอาต์พุตโมเดล ตัวอย่างเช่น คุณจะ อาจเพิ่มอุณหภูมิเมื่อสร้างแอปพลิเคชันที่ สร้างเอาต์พุตเชิงสร้างสรรค์ ในทางกลับกัน คุณอาจลดอุณหภูมิลงได้ เมื่อสร้างโมเดลที่จัดหมวดหมู่รูปภาพหรือข้อความเพื่อปรับปรุง ความถูกต้องและความสอดคล้องของโมเดล

อุณหภูมิมักจะใช้กับ softmax

ช่วงข้อความ

ช่วงดัชนีอาร์เรย์ที่เชื่อมโยงกับส่วนย่อยที่เฉพาะเจาะจงของสตริงข้อความ

เช่น คำว่า good ในสตริง Python s="Be good now" ตรง

ช่วงข้อความจาก 3 ถึง 6

โทเค็น

ในโมเดลภาษา หน่วยอะตอมที่เป็นโมเดล และคาดการณ์ได้ โทเค็นมักจะเป็นหนึ่งใน ดังต่อไปนี้:

- คำ เช่น วลี "สุนัขชอบแมว" ประกอบด้วยคำ 3 คำ โทเค็น: "สุนัข" "ชอบ" และ "แมว"

- อักขระ ตัวอย่างเช่น วลี "ปลาจักรยาน" ประกอบด้วย 9 โทเค็นอักขระ (โปรดทราบว่าช่องว่างนั้นนับเป็นหนึ่งในโทเค็น)

- คำย่อย ซึ่งคำหนึ่งคำอาจเป็นโทเค็นเดียวหรือหลายโทเค็นก็ได้ คำย่อยประกอบด้วยคำราก คำนำหน้า หรือคำต่อท้าย ตัวอย่างเช่น โมเดลภาษาที่ใช้คำย่อยเป็นโทเค็นอาจดูคำว่า "สุนัข" เป็นโทเค็น 2 รายการ (รากคำว่า "สุนัข" และคำต่อท้ายพหูพจน์ "s") เหมือนเดิม โมเดลภาษาอาจมองเห็นคำเดียวที่ "สูงขึ้น" เป็นคำย่อยสองคำ ( รากคำ "สูง" และคำต่อท้าย "er")

ในโดเมนนอกโมเดลภาษา โทเค็นสามารถแสดง หน่วยอะตอม เช่น ในคอมพิวเตอร์วิทัศน์ โทเค็นอาจเป็นชุดย่อย รูปภาพ

Transformer

สถาปัตยกรรมโครงข่ายระบบประสาทเทียมที่พัฒนาที่ Google ซึ่ง อาศัยกลไกการเอาใจใส่ตนเองเพื่อเปลี่ยนรูปแบบ ลำดับของอินพุตที่ฝังเข้าไปในลำดับเอาต์พุต ฝังโดยไม่ต้องอาศัย Convolution หรือ โครงข่ายประสาทแบบเกิดซ้ำ ตัว Transformer สามารถ แสดงเป็นกลุ่มของเลเยอร์ ที่ให้ความสนใจตนเอง

ตัวเปลี่ยนรูปแบบอาจประกอบด้วยสิ่งต่อไปนี้

- โปรแกรมเปลี่ยนไฟล์

- ตัวถอดรหัส

- ทั้งโปรแกรมเปลี่ยนไฟล์และโปรแกรมถอดรหัส

โปรแกรมเปลี่ยนไฟล์จะแปลงลำดับการฝังเป็นลำดับใหม่ของ ด้วยความยาวที่เท่ากัน โปรแกรมเปลี่ยนไฟล์มีเลเยอร์ที่เหมือนกัน N ชั้น ซึ่งแต่ละชั้นมี 2 ชั้น เลเยอร์ย่อย ระบบจะใช้เลเยอร์ย่อย 2 เลเยอร์นี้ที่แต่ละตำแหน่งของอินพุต การฝังลำดับ ซึ่งจะเปลี่ยนรูปแบบองค์ประกอบแต่ละรายการของลำดับให้เป็น การฝังวิดีโอ เลเยอร์ย่อยของโปรแกรมเปลี่ยนไฟล์แรกจะรวบรวมข้อมูลจาก ลำดับการป้อนข้อมูล เลเยอร์ย่อยของโปรแกรมเปลี่ยนไฟล์ที่ 2 จะเปลี่ยนรูปแบบการรวม ข้อมูลลงในเอาต์พุตที่ฝัง

ตัวถอดรหัสจะแปลงลำดับอินพุตที่ฝังเป็นลำดับ การฝังเอาต์พุต อาจมีความยาวต่างกันก็ได้ ตัวถอดรหัสยังประกอบด้วย เลเยอร์ที่เหมือนกัน N เลเยอร์ซึ่งมีเลเยอร์ย่อยสามเลเยอร์ โดยสองเลเยอร์มีลักษณะคล้ายกับ และเลเยอร์ย่อยของโปรแกรมเปลี่ยนไฟล์ เลเยอร์ย่อยของตัวถอดรหัสรายการที่ 3 จะนำเอาต์พุตของ โปรแกรมเปลี่ยนไฟล์และใช้กลไกการตั้งความสนใจของตนเองกับ รวบรวมข้อมูลได้

บล็อกโพสต์ Transformer: A Novel Network Architecture for Language ความเข้าใจ เป็นข้อมูลเบื้องต้นที่ดีเกี่ยวกับ Transformers

Trigram

N-gram ที่มี N=3

U

ทิศทางเดียว

ระบบที่ประเมินเฉพาะข้อความที่อยู่ก่อนส่วนเป้าหมายของข้อความ ในทางตรงกันข้าม ระบบแบบ 2 ทิศทางจะประเมินทั้ง ข้อความที่อยู่ก่อนหน้าและตามหลังส่วนเป้าหมายของข้อความ ดูรายละเอียดเพิ่มเติมได้ที่แบบ 2 ทาง

โมเดลภาษาแบบทิศทางเดียว

โมเดลภาษาที่พิจารณาความน่าจะเป็นจาก โทเค็นที่ปรากฏก่อน ไม่ใช่หลังโทเค็นเป้าหมาย แตกต่างจากโมเดลภาษาแบบ 2 ทิศทาง

V

โปรแกรมเปลี่ยนไฟล์อัตโนมัติแบบผันแปร (VAE)

โปรแกรมเปลี่ยนไฟล์อัตโนมัติประเภทหนึ่งที่ใช้ประโยชน์จากความคลาดเคลื่อน ระหว่างอินพุตและเอาต์พุตเพื่อสร้างอินพุตเวอร์ชันที่แก้ไขแล้ว โปรแกรมเปลี่ยนไฟล์อัตโนมัติรูปแบบต่างๆ มีประโยชน์สําหรับ Generative AI

VAE จะอิงตามการอนุมานเชิงแปรผัน ซึ่งเป็นเทคนิคในการประมาณค่า พารามิเตอร์ของโมเดลความน่าจะเป็น

W

การฝังคำ

นำเสนอแต่ละคำในชุดคำภายในแท็ก เวกเตอร์การฝัง; ซึ่งก็คือการแทนคำแต่ละคำในรูปแบบ เวกเตอร์ของค่าจุดลอยตัวระหว่าง 0.0 ถึง 1.0 คำที่คล้ายกัน ที่มีความหมายคล้ายกันมากกว่าคำที่มีความหมายต่างกัน เช่น แครอท คึ่นช่าย และแตงกวา การเป็นตัวแทนที่คล้ายกัน ซึ่งจะแตกต่างอย่างมากจากการนำเสนอ ของเครื่องบิน แว่นกันแดด และยาสีฟัน

Z

ข้อความแจ้งการตั้งค่า Zero-shot

ข้อความแจ้งที่ไม่มีตัวอย่างวิธีที่ต้องการ โมเดลภาษาขนาดใหญ่เพื่อตอบกลับ เช่น

| ส่วนต่างๆ ของพรอมต์ | หมายเหตุ |

|---|---|

| สกุลเงินอย่างเป็นทางการของประเทศที่ระบุคืออะไร | คำถามที่ต้องการให้ LLM ตอบ |

| อินเดีย: | การค้นหาจริง |

โมเดลภาษาขนาดใหญ่อาจตอบสนองด้วยสิ่งต่อไปนี้

- รูปี

- INR

- ₹

- รูปีอินเดีย

- รูปี

- รูปีอินเดีย

คำตอบทั้งหมดถูกต้อง แต่คุณอาจชอบรูปแบบใดรูปแบบหนึ่ง

เปรียบเทียบและเปรียบต่างกับการแสดงข้อความแจ้ง Zero Shot กับคำต่อไปนี้